XlaBuilder ইন্টারফেসে সংজ্ঞায়িত অপারেশনের শব্দার্থবিদ্যা নিচে বর্ণনা করা হল। সাধারণত, এই অপারেশনগুলি xla_data.proto এ RPC ইন্টারফেসে সংজ্ঞায়িত অপারেশনের সাথে এক-এক ম্যাপ করে।

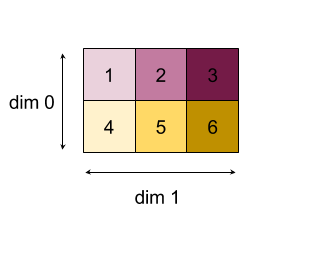

নামকরণ সম্পর্কে একটি নোট: সাধারণীকৃত ডেটা টাইপ XLA হল একটি N-মাত্রিক অ্যারে যা কিছু অভিন্ন ধরণের উপাদান ধারণ করে (যেমন 32-বিট ফ্লোট)। ডকুমেন্টেশন জুড়ে, অ্যারে একটি ইচ্ছাকৃত-মাত্রিক অ্যারে বোঝাতে ব্যবহৃত হয়। সুবিধার জন্য, বিশেষ ক্ষেত্রে আরও নির্দিষ্ট এবং পরিচিত নাম রয়েছে; উদাহরণস্বরূপ, একটি ভেক্টর একটি 1-মাত্রিক অ্যারে এবং একটি ম্যাট্রিক্স একটি 2-মাত্রিক অ্যারে।

শেপস অ্যান্ড লেআউট এবং টাইল্ড লেআউট -এ একটি অপের গঠন সম্পর্কে আরও জানুন।

পেটের পেশী

আরও দেখুন XlaBuilder::Abs ।

উপাদান অনুসারে abs x -> |x| ।

Abs(operand)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

StableHLO তথ্যের জন্য StableHLO - abs দেখুন।

যোগ করুন

আরও দেখুন XlaBuilder::Add ।

lhs এবং rhs এর উপাদান-ভিত্তিক যোগ সম্পাদন করে।

Add(lhs, rhs)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

আর্গুমেন্টের আকারগুলি হয় একই রকম অথবা সামঞ্জস্যপূর্ণ হতে হবে। আকারগুলির সামঞ্জস্যপূর্ণ হওয়ার অর্থ কী তা সম্পর্কে সম্প্রচার ডকুমেন্টেশন দেখুন। একটি অপারেশনের ফলাফলের একটি আকৃতি থাকে যা দুটি ইনপুট অ্যারে সম্প্রচারের ফলাফল। এই ভেরিয়েন্টে, বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে ক্রিয়াকলাপ সমর্থিত নয় , যদি না অপারেন্ডগুলির মধ্যে একটি স্কেলার হয়।

Add: এর জন্য ভিন্ন-মাত্রিক সম্প্রচার সমর্থন সহ একটি বিকল্প রূপ বিদ্যমান।

Add(lhs,rhs, broadcast_dimensions)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| সম্প্রচার_মাত্রা | অ্যারেস্লাইস | অপারেন্ড আকৃতির প্রতিটি মাত্রা লক্ষ্য আকৃতিতে কোন মাত্রার সাথে মিলে যায়? |

এই ধরণের অপারেশনটি বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে গাণিতিক ক্রিয়াকলাপের জন্য ব্যবহার করা উচিত (যেমন একটি ভেক্টরে একটি ম্যাট্রিক্স যোগ করা)।

অতিরিক্ত broadcast_dimensions অপারেন্ড হল পূর্ণসংখ্যার একটি অংশ যা অপারেন্ড সম্প্রচারের জন্য ব্যবহৃত মাত্রা নির্দিষ্ট করে। শব্দার্থবিদ্যা সম্প্রচার পৃষ্ঠায় বিস্তারিতভাবে বর্ণনা করা হয়েছে।

StableHLO তথ্যের জন্য StableHLO - add দেখুন।

নির্ভরতা যোগ করুন

আরও দেখুন HloInstruction::AddDependency ।

HLO ডাম্পগুলিতে AddDependency প্রদর্শিত হতে পারে, কিন্তু এগুলি শেষ ব্যবহারকারীদের দ্বারা ম্যানুয়ালি তৈরি করার উদ্দেশ্যে নয়।

সর্বোপরি

আরও দেখুন XlaBuilder::AfterAll ।

AfterAll বিভিন্ন সংখ্যক টোকেন নেয় এবং একটি একক টোকেন তৈরি করে। টোকেন হল আদিম প্রকার যা পার্শ্ব-প্রতিক্রিয়াশীল ক্রিয়াকলাপগুলির মধ্যে থ্রেড করা যেতে পারে যাতে অর্ডার কার্যকর করা যায়। AfterAll অপারেশনের একটি সেটের পরে একটি অপারেশন অর্ডার করার জন্য টোকেনের একটি সংযোগ হিসাবে ব্যবহার করা যেতে পারে।

AfterAll(tokens)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

tokens | XlaOp এর ভেক্টর | টোকেনের বিভিন্ন সংখ্যা |

StableHLO তথ্যের জন্য StableHLO - after_all দেখুন।

অলগ্যাদার

আরও দেখুন XlaBuilder::AllGather ।

প্রতিলিপি জুড়ে সংযোজন সম্পাদন করে।

AllGather(operand, all_gather_dimension, shard_count, replica_groups, channel_id, layout, use_global_device_ids)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | প্রতিলিপি জুড়ে সংযুক্ত করার জন্য অ্যারে |

all_gather_dimension | int64 | সংযোজন মাত্রা |

shard_count | int64 | প্রতিটি প্রতিরূপ গোষ্ঠীর আকার |

replica_groups | int64 এর ভেক্টরগুলির ভেক্টর | যেসব গোষ্ঠীর মধ্যে সংযোগ স্থাপন করা হয় |

channel_id | ঐচ্ছিক ChannelHandle | ক্রস-মডিউল যোগাযোগের জন্য ঐচ্ছিক চ্যানেল আইডি |

layout | ঐচ্ছিক Layout | একটি লেআউট প্যাটার্ন তৈরি করে যা আর্গুমেন্টে মিলিত লেআউটটি ক্যাপচার করবে। |

use_global_device_ids | ঐচ্ছিক bool | ReplicaGroup কনফিগারেশনের আইডিগুলো যদি গ্লোবাল আইডি প্রতিনিধিত্ব করে তাহলে true রিটার্ন করে। |

-

replica_groupsহল এমন একটি তালিকা যার মধ্যে কনক্যাটেনেশন করা হয় (বর্তমান রেপ্লিকার জন্য রেপ্লিকা আইডিReplicaIdব্যবহার করে পুনরুদ্ধার করা যেতে পারে)। প্রতিটি গ্রুপের রেপ্লিকাগুলির ক্রম নির্ধারণ করে যে ফলাফলে তাদের ইনপুটগুলি কোন ক্রমে অবস্থিত।replica_groupsহয় খালি থাকতে হবে (যে ক্ষেত্রে সমস্ত রেপ্লিকা একটি একক গ্রুপের অন্তর্গত,0থেকেN - 1পর্যন্ত ক্রমযুক্ত), অথবা রেপ্লিকাগুলির সংখ্যার সমান সংখ্যক উপাদান থাকতে হবে। উদাহরণস্বরূপ,replica_groups = {0, 2}, {1, 3}0এবং2, এবং1এবং3রেপ্লিকাগুলির মধ্যে কনক্যাটেনেশন করে। -

shard_countহল প্রতিটি রেপ্লিকা গ্রুপের আকার। যেখানেreplica_groupsখালি থাকে, সেখানে আমাদের এটি প্রয়োজন। -

channel_idক্রস-মডিউল যোগাযোগের জন্য ব্যবহৃত হয়: শুধুমাত্র একইchannel_idসহall-gatherঅপারেশনগুলি একে অপরের সাথে যোগাযোগ করতে পারে। -

use_global_device_idsযদি ReplicaGroup কনফিগারেশনের আইডিগুলি একটি replica id এর পরিবর্তে (replica_id * partition_count + partition_id) এর একটি গ্লোবাল আইডি উপস্থাপন করে তবে true রিটার্ন করে। যদি এই অল-রিডুস ক্রস-পার্টিশন এবং ক্রস-রেপ্লিকা উভয়ই হয় তবে এটি ডিভাইসগুলির আরও নমনীয় গ্রুপিং সক্ষম করে।

আউটপুট আকৃতি হল ইনপুট আকৃতি যেখানে all_gather_dimension কে shard_count গুণ বড় করা হয়েছে। উদাহরণস্বরূপ, যদি দুটি প্রতিলিপি থাকে এবং দুটি প্রতিলিপিতে অপারেন্ডের মান যথাক্রমে [1.0, 2.5] এবং [3.0, 5.25] থাকে, তাহলে এই অপশন থেকে আউটপুট মান যেখানে all_gather_dim 0 হয় উভয় প্রতিলিপিতে [1.0, 2.5, 3.0,5.25] হবে।

AllGather এর API অভ্যন্তরীণভাবে 2টি HLO নির্দেশাবলীতে বিভক্ত ( AllGatherStart এবং AllGatherDone )।

আরও দেখুন HloInstruction::CreateAllGatherStart ।

AllGatherStart , AllGatherDone HLO তে আদিম হিসেবে কাজ করে। এই অপশনগুলি HLO ডাম্পে প্রদর্শিত হতে পারে, কিন্তু এগুলি শেষ ব্যবহারকারীদের দ্বারা ম্যানুয়ালি তৈরি করার উদ্দেশ্যে নয়।

StableHLO তথ্যের জন্য StableHLO - all_gather দেখুন।

AllReduce সম্পর্কে

আরও দেখুন XlaBuilder::AllReduce ।

প্রতিলিপি জুড়ে একটি কাস্টম গণনা সম্পাদন করে।

AllReduce(operand, computation, replica_groups, channel_id, shape_with_layout, use_global_device_ids)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | অ্যারে অথবা খালি না থাকা অ্যারের একটি টুপল যা প্রতিলিপি জুড়ে হ্রাস করবে |

computation | XlaComputation | হ্রাস গণনা |

replica_groups | ReplicaGroup ভেক্টর | যেসব গ্রুপের মধ্যে হ্রাস করা হয় |

channel_id | ঐচ্ছিক ChannelHandle | ক্রস-মডিউল যোগাযোগের জন্য ঐচ্ছিক চ্যানেল আইডি |

shape_with_layout | ঐচ্ছিক Shape | স্থানান্তরিত ডেটার লেআউট নির্ধারণ করে |

use_global_device_ids | ঐচ্ছিক bool | ReplicaGroup কনফিগারেশনের আইডিগুলো যদি গ্লোবাল আইডি প্রতিনিধিত্ব করে তাহলে true রিটার্ন করে। |

- যখন

operandঅ্যারের একটি টুপল হয়, তখন টুপলের প্রতিটি এলিমেন্টে অল-রিডুস সঞ্চালিত হয়। -

replica_groupsহল রেপ্লিকা গ্রুপের একটি তালিকা যার মধ্যে রিডাকশন করা হয় (বর্তমান রেপ্লিকার জন্য রেপ্লিকা আইডিReplicaIdব্যবহার করে পুনরুদ্ধার করা যেতে পারে)।replica_groupsহয় খালি থাকতে হবে (যে ক্ষেত্রে সমস্ত রেপ্লিকা একটি একক গ্রুপের অন্তর্গত), অথবা রেপ্লিকার সংখ্যার সমান সংখ্যক উপাদান থাকতে হবে। উদাহরণস্বরূপ,replica_groups = {0, 2}, {1, 3}রেপ্লিকা0এবং2এবং1এবং3এর মধ্যে রিডাকশন করে। -

channel_idক্রস-মডিউল যোগাযোগের জন্য ব্যবহৃত হয়: শুধুমাত্র একইchannel_idসহall-reduceঅপারেশনগুলি একে অপরের সাথে যোগাযোগ করতে পারে। -

shape_with_layout: AllReduce এর লেআউটকে প্রদত্ত লেআউটে জোর করে। এটি আলাদাভাবে কম্পাইল করা AllReduce অপশনের একটি গ্রুপের জন্য একই লেআউট নিশ্চিত করতে ব্যবহৃত হয়। -

use_global_device_idsযদি ReplicaGroup কনফিগারেশনের আইডিগুলি একটি replica id এর পরিবর্তে (replica_id * partition_count + partition_id) এর একটি গ্লোবাল আইডি উপস্থাপন করে তবে true রিটার্ন করে। যদি এই অল-রিডুস ক্রস-পার্টিশন এবং ক্রস-রেপ্লিকা উভয়ই হয় তবে এটি ডিভাইসগুলির আরও নমনীয় গ্রুপিং সক্ষম করে।

আউটপুট আকৃতি ইনপুট আকৃতির মতোই। উদাহরণস্বরূপ, যদি দুটি প্রতিলিপি থাকে এবং দুটি প্রতিলিপিতে অপারেন্ডের মান যথাক্রমে [1.0, 2.5] এবং [3.0, 5.25] থাকে, তাহলে এই অপ এবং সমীকরণ গণনা থেকে আউটপুট মান উভয় প্রতিলিপিতে [4.0, 7.75] হবে। যদি ইনপুটটি একটি টুপল হয়, তাহলে আউটপুটটিও একটি টুপল হবে।

AllReduce এর ফলাফল গণনা করার জন্য প্রতিটি রেপ্লিকা থেকে একটি ইনপুট থাকা প্রয়োজন, তাই যদি একটি রেপ্লিকা একটি AllReduce নোড অন্যটির চেয়ে বেশি বার চালায়, তাহলে পূর্ববর্তী রেপ্লিকাটি চিরকাল অপেক্ষা করবে। যেহেতু রেপ্লিকাগুলি একই প্রোগ্রাম চালাচ্ছে, তাই এটি হওয়ার খুব বেশি উপায় নেই, তবে এটি সম্ভব যখন একটি while লুপের অবস্থা infeed থেকে প্রাপ্ত ডেটার উপর নির্ভর করে এবং infeed থাকা ডেটা while লুপকে একটি রেপ্লিকাতে অন্যটির চেয়ে বেশি বার পুনরাবৃত্তি করে।

AllReduce এর API অভ্যন্তরীণভাবে 2টি HLO নির্দেশাবলীতে বিভক্ত ( AllReduceStart এবং AllReduceDone )।

আরও দেখুন HloInstruction::CreateAllReduceStart ।

AllReduceStart এবং AllReduceDone HLO তে প্রিমিটিভ হিসেবে কাজ করে। এই অপশনগুলি HLO ডাম্পে প্রদর্শিত হতে পারে, কিন্তু এগুলি শেষ ব্যবহারকারীদের দ্বারা ম্যানুয়ালি তৈরি করার উদ্দেশ্যে নয়।

ক্রসরেপ্লিকাসাম

আরও দেখুন XlaBuilder::CrossReplicaSum ।

একটি সমষ্টি গণনার মাধ্যমে AllReduce সম্পাদন করে।

CrossReplicaSum(operand, replica_groups)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp সম্পর্কে | অ্যারে অথবা খালি না থাকা অ্যারের একটি টুপল যা প্রতিলিপি জুড়ে হ্রাস করবে |

replica_groups | int64 এর ভেক্টরগুলির ভেক্টর | যেসব গ্রুপের মধ্যে হ্রাস করা হয় |

প্রতিটি উপগোষ্ঠীর রেপ্লিকাগুলির মধ্যে অপারেন্ড মানের যোগফল প্রদান করে। সমস্ত প্রতিলিপি যোগফলকে একটি ইনপুট সরবরাহ করে এবং সমস্ত প্রতিলিপি প্রতিটি উপগোষ্ঠীর জন্য ফলাফলের যোগফল গ্রহণ করে।

সকলের জন্য

আরও দেখুন XlaBuilder::AllToAll ।

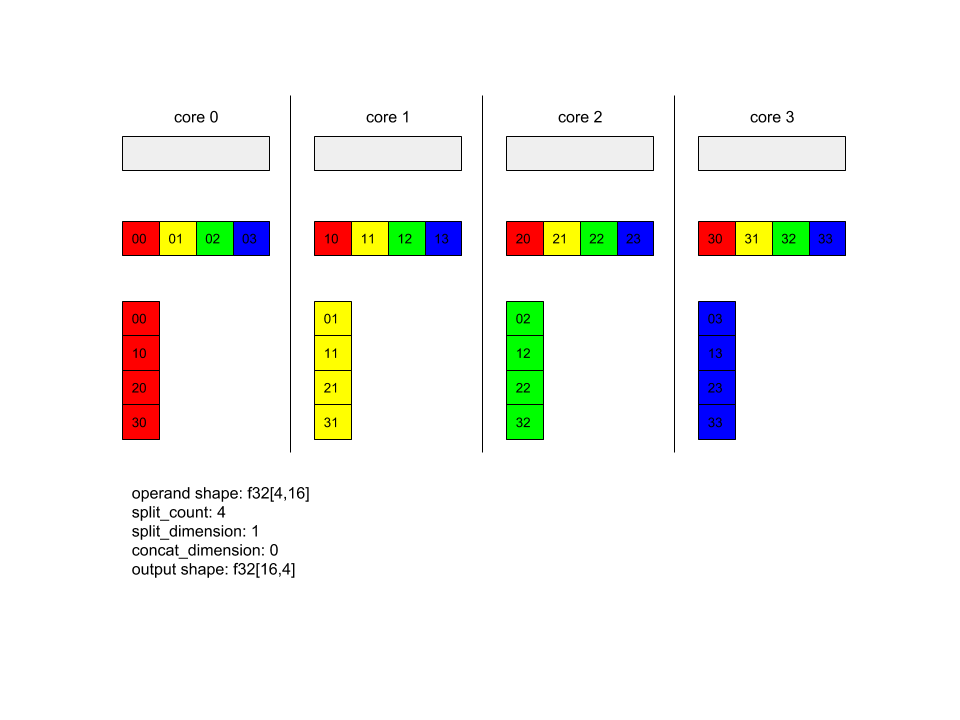

AllToAll একটি সম্মিলিত অপারেশন যা সমস্ত কোর থেকে সমস্ত কোরে ডেটা পাঠায়। এর দুটি ধাপ রয়েছে:

- স্ক্যাটার ফেজ। প্রতিটি কোরে, অপারেন্ডটি

split_dimensionsবরাবরsplit_countসংখ্যক ব্লকে বিভক্ত হয় এবং ব্লকগুলি সমস্ত কোরে ছড়িয়ে ছিটিয়ে থাকে, যেমন, ith ব্লকটি ith কোরে পাঠানো হয়। - সংগ্রহের পর্যায়। প্রতিটি কোর

concat_dimensionবরাবর প্রাপ্ত ব্লকগুলিকে একত্রিত করে।

অংশগ্রহণকারী কোরগুলি নিম্নলিখিতভাবে কনফিগার করা যেতে পারে:

-

replica_groups: প্রতিটি ReplicaGroup-এ গণনায় অংশগ্রহণকারী replica id-এর একটি তালিকা থাকে (বর্তমান replica-এর replica idReplicaIdব্যবহার করে পুনরুদ্ধার করা যেতে পারে)। AllToAll নির্দিষ্ট ক্রমে উপগোষ্ঠীর মধ্যে প্রয়োগ করা হবে। উদাহরণস্বরূপ,replica_groups = { {1,2,3}, {4,5,0} }এর অর্থ হল একটি AllToAll replicas{1, 2, 3}এর মধ্যে এবং সংগ্রহ পর্যায়ে প্রয়োগ করা হবে, এবং প্রাপ্ত ব্লকগুলি 1, 2, 3 এর একই ক্রমে সংযুক্ত করা হবে। তারপর, 4, 5, 0 প্রতিলিপির মধ্যে আরেকটি AllToAll প্রয়োগ করা হবে এবং সংযুক্তকরণ ক্রমও 4, 5, 0। যদিreplica_groupsখালি থাকে, তাহলে সমস্ত প্রতিলিপি তাদের উপস্থিতির সংযুক্তকরণ ক্রমে একটি গোষ্ঠীর অন্তর্গত।

পূর্বশর্ত:

-

split_dimensionএ অপারেন্ডের মাত্রার আকারsplit_countদ্বারা বিভাজ্য। - অপারেন্ডের আকৃতি টুপল নয়।

AllToAll(operand, split_dimension, concat_dimension, split_count, replica_groups, layout, channel_id)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | n মাত্রিক ইনপুট অ্যারে |

split_dimension | int64 | [0,n) ব্যবধানের একটি মান যা অপারেন্ডটি যে মাত্রা বরাবর বিভক্ত তা নির্দেশ করে |

concat_dimension | int64 | ব্যবধান [0,n) এর একটি মান যা বিভক্ত ব্লকগুলিকে সংযুক্ত করার মাত্রার নাম দেয় |

split_count | int64 | এই অপারেশনে অংশগ্রহণকারী কোরের সংখ্যা। যদি replica_groups খালি থাকে, তাহলে এটি প্রতিলিপির সংখ্যা হওয়া উচিত; অন্যথায়, এটি প্রতিটি গ্রুপের প্রতিলিপির সংখ্যার সমান হওয়া উচিত। |

replica_groups | ReplicaGroup ভেক্টর | প্রতিটি গ্রুপে রেপ্লিকা আইডির একটি তালিকা থাকে। |

layout | ঐচ্ছিক Layout | ব্যবহারকারী-নির্দিষ্ট মেমরি লেআউট |

channel_id | ঐচ্ছিক ChannelHandle | প্রতিটি সেন্ড/রেকভি জোড়ার জন্য অনন্য শনাক্তকারী |

আকার এবং লেআউট সম্পর্কে আরও তথ্যের জন্য xla::shapes দেখুন।

StableHLO তথ্যের জন্য StableHLO - all_to_all দেখুন।

AllToAll - উদাহরণ ১।

XlaBuilder b("alltoall");

auto x = Parameter(&b, 0, ShapeUtil::MakeShape(F32, {4, 16}), "x");

AllToAll(

x,

/*split_dimension=*/ 1,

/*concat_dimension=*/ 0,

/*split_count=*/ 4);

উপরের উদাহরণে, Alltoall-এ ৪টি কোর অংশগ্রহণ করছে। প্রতিটি কোরে, অপারেন্ডটি মাত্রা ১ বরাবর ৪টি অংশে বিভক্ত, তাই প্রতিটি অংশের আকৃতি f32[4,4]। ৪টি অংশ সমস্ত কোরে ছড়িয়ে ছিটিয়ে থাকে। তারপর প্রতিটি কোর প্রাপ্ত অংশগুলিকে মাত্রা ০ বরাবর, কোর ০-৪ এর ক্রমানুসারে সংযুক্ত করে। সুতরাং প্রতিটি কোরের আউটপুট f32[16,4] আকার ধারণ করে।

AllToAll - উদাহরণ ২ - StableHLO

উপরের উদাহরণে, AllToAll-এ ২টি প্রতিলিপি অংশগ্রহণ করছে। প্রতিটি প্রতিলিপিতে, অপারেন্ডের আকৃতি f32[2,4]। অপারেন্ডটি মাত্রা ১ বরাবর ২টি অংশে বিভক্ত, তাই প্রতিটি অংশের আকৃতি f32[2,2]। এরপর ২টি অংশ প্রতিলিপি গ্রুপে তাদের অবস্থান অনুসারে প্রতিলিপিগুলিতে বিনিময় করা হয়। প্রতিটি প্রতিলিপি উভয় অপারেন্ড থেকে তার সংশ্লিষ্ট অংশ সংগ্রহ করে এবং মাত্রা ০ বরাবর তাদের সংযুক্ত করে। ফলস্বরূপ, প্রতিটি প্রতিলিপির আউটপুট f32[4,2] আকৃতির হয়।

র্যাগডঅলটুঅল

আরও দেখুন XlaBuilder::RaggedAllToAll ।

RaggedAllToAll একটি সম্মিলিত অল-টু-অল অপারেশন সম্পাদন করে, যেখানে ইনপুট এবং আউটপুট হল র্যাগড টেনসর।

RaggedAllToAll(input, input_offsets, send_sizes, output, output_offsets, recv_sizes, replica_groups, channel_id)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

input | XlaOp | T ধরণের N অ্যারে |

input_offsets | XlaOp | T ধরণের N অ্যারে |

send_sizes | XlaOp | T ধরণের N অ্যারে |

output | XlaOp | T ধরণের N অ্যারে |

output_offsets | XlaOp | T ধরণের N অ্যারে |

recv_sizes | XlaOp | T ধরণের N অ্যারে |

replica_groups | ReplicaGroup ভেক্টর | প্রতিটি গ্রুপে রেপ্লিকা আইডির একটি তালিকা থাকে। |

channel_id | ঐচ্ছিক ChannelHandle | প্রতিটি সেন্ড/রেকভি জোড়ার জন্য অনন্য শনাক্তকারী |

র্যাগড টেনসর তিনটি টেনসরের সেট দ্বারা সংজ্ঞায়িত করা হয়:

-

data:dataটেনসরটি তার বাইরেরতম মাত্রা বরাবর "র্যাগড", যার সাথে প্রতিটি সূচীকৃত উপাদানের পরিবর্তনশীল আকার রয়েছে। -

offsets':offsetsটেনসরdataটেনসরের বাইরেরতম মাত্রাকে সূচিত করে এবংdataটেনসরের প্রতিটি র্যাগড এলিমেন্টের শুরুর অফসেটকে প্রতিনিধিত্ব করে। -

sizes:sizestensordataটেনসরের প্রতিটি র্যাগড এলিমেন্টের আকার প্রতিনিধিত্ব করে, যেখানে আকারটি উপ-উপাদানের এককগুলিতে নির্দিষ্ট করা হয়। একটি উপ-উপাদানকে 'ডেটা' টেনসর আকৃতির প্রত্যয় হিসাবে সংজ্ঞায়িত করা হয় যা সবচেয়ে বাইরের "র্যাগড" মাত্রা অপসারণ করে প্রাপ্ত হয়। -

offsetsএবংsizesটেনসরগুলির আকার একই হতে হবে।

র্যাগড টেনসরের একটি উদাহরণ:

data: [8,3] =

{ {a,b,c},{d,e,f},{g,h,i},{j,k,l},{m,n,o},{p,q,r},{s,t,u},{v,w,x} }

offsets: [3] = {0, 1, 4}

sizes: [3] = {1, 3, 4}

// Index 'data' at 'offsets'[0], 'sizes'[0]' // {a,b,c}

// Index 'data' at 'offsets'[1], 'sizes'[1]' // {d,e,f},{g,h,i},{j,k,l}

// Index 'data' at 'offsets'[2], 'sizes'[2]' // {m,n,o},{p,q,r},{s,t,u},{v,w,x}

output_offsets এমনভাবে sharded করতে হবে যাতে প্রতিটি রেপ্লিকা লক্ষ্য রেপ্লিকা আউটপুট দৃষ্টিকোণে অফসেট ধারণ করে।

i-th আউটপুট অফসেটের জন্য, বর্তমান রেপ্লিকাটি input[input_offsets[i]:input_offsets[i]+input_sizes[i]] আপডেট i -th replica তে পাঠাবে যা i -th replica output তে output_i[output_offsets[i]:output_offsets[i]+send_sizes[i]] তে output হবে।

উদাহরণস্বরূপ, যদি আমাদের 2টি প্রতিলিপি থাকে:

replica 0:

input: [1, 2, 2]

output:[0, 0, 0, 0]

input_offsets: [0, 1]

send_sizes: [1, 2]

output_offsets: [0, 0]

recv_sizes: [1, 1]

replica 1:

input: [3, 4, 0]

output: [0, 0, 0, 0]

input_offsets: [0, 1]

send_sizes: [1, 1]

output_offsets: [1, 2]

recv_sizes: [2, 1]

// replica 0's result will be: [1, 3, 0, 0]

// replica 1's result will be: [2, 2, 4, 0]

র্যাগড অল-টু-অল এইচএলও-এর নিম্নলিখিত যুক্তি রয়েছে:

-

input: র্যাগড ইনপুট ডেটা টেনসর। -

output: র্যাগড আউটপুট ডেটা টেনসর। -

input_offsets: র্যাগড ইনপুট অফসেট টেনসর। -

send_sizes: র্যাগড সেন্ড সাইজ টেনসর। -

output_offsets: টার্গেট রেপ্লিকা আউটপুটে র্যাগড অফসেটের অ্যারে। -

recv_sizes: র্যাগড recv সাইজ টেনসর।

*_offsets এবং *_sizes টেনসরগুলির আকৃতি একই হতে হবে।

*_offsets এবং *_sizes টেনসরের জন্য দুটি আকার সমর্থিত:

-

[num_devices]যেখানে ragged-all-to-all রেপ্লিকা গ্রুপের প্রতিটি রিমোট ডিভাইসে সর্বাধিক একটি আপডেট পাঠাতে পারে। উদাহরণস্বরূপ:

for (remote_device_id : replica_group) {

SEND input[input_offsets[remote_device_id]],

output[output_offsets[remote_device_id]],

send_sizes[remote_device_id] }

[num_devices, num_updates]যেখানে ragged-all-to-all রেপ্লিকা গ্রুপের প্রতিটি রিমোট ডিভাইসের জন্য একই রিমোট ডিভাইসে (প্রতিটি ভিন্ন অফসেটে)num_updatesআপডেট পাঠাতে পারে।

উদাহরণস্বরূপ:

for (remote_device_id : replica_group) {

for (update_idx : num_updates) {

SEND input[input_offsets[remote_device_id][update_idx]],

output[output_offsets[remote_device_id][update_idx]]],

send_sizes[remote_device_id][update_idx] } }

এবং

আরও দেখুন XlaBuilder::And ।

দুটি টেনসর lhs এবং rhs এর উপাদান-ভিত্তিক AND সম্পাদন করে।

And(lhs, rhs)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

আর্গুমেন্টের আকারগুলি হয় একই রকম অথবা সামঞ্জস্যপূর্ণ হতে হবে। আকারগুলির সামঞ্জস্যপূর্ণ হওয়ার অর্থ কী তা সম্পর্কে সম্প্রচার ডকুমেন্টেশন দেখুন। একটি অপারেশনের ফলাফলের একটি আকৃতি থাকে যা দুটি ইনপুট অ্যারে সম্প্রচারের ফলাফল। এই ভেরিয়েন্টে, বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে ক্রিয়াকলাপ সমর্থিত নয় , যদি না অপারেন্ডগুলির মধ্যে একটি স্কেলার হয়।

And-এর জন্য ভিন্ন-মাত্রিক সম্প্রচার সমর্থন সহ একটি বিকল্প রূপ বিদ্যমান:

And(lhs,rhs, broadcast_dimensions)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| সম্প্রচার_মাত্রা | অ্যারেস্লাইস | অপারেন্ড আকৃতির প্রতিটি মাত্রা লক্ষ্য আকৃতিতে কোন মাত্রার সাথে মিলে যায়? |

এই ধরণের অপারেশনটি বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে গাণিতিক ক্রিয়াকলাপের জন্য ব্যবহার করা উচিত (যেমন একটি ভেক্টরে একটি ম্যাট্রিক্স যোগ করা)।

অতিরিক্ত broadcast_dimensions অপারেন্ড হল পূর্ণসংখ্যার একটি অংশ যা অপারেন্ড সম্প্রচারের জন্য ব্যবহৃত মাত্রা নির্দিষ্ট করে। শব্দার্থবিদ্যা সম্প্রচার পৃষ্ঠায় বিস্তারিতভাবে বর্ণনা করা হয়েছে।

StableHLO তথ্যের জন্য StableHLO - এবং দেখুন।

অ্যাসিঙ্ক

আরও দেখুন HloInstruction::CreateAsyncStart , HloInstruction::CreateAsyncUpdate , HloInstruction::CreateAsyncDone ।

AsyncDone , AsyncStart , এবং AsyncUpdate হল অভ্যন্তরীণ HLO নির্দেশাবলী যা অ্যাসিঙ্ক্রোনাস অপারেশনের জন্য ব্যবহৃত হয় এবং HLO তে আদিম হিসেবে কাজ করে। এই অপারেশনগুলি HLO ডাম্পে প্রদর্শিত হতে পারে কিন্তু এগুলি শেষ ব্যবহারকারীদের দ্বারা ম্যানুয়ালি তৈরি করার উদ্দেশ্যে নয়।

Atan2 সম্পর্কে

আরও দেখুন XlaBuilder::Atan2 ।

lhs এবং rhs এ উপাদান-ভিত্তিক atan2 অপারেশন সম্পাদন করে।

Atan2(lhs, rhs)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

আর্গুমেন্টের আকারগুলি হয় একই রকম অথবা সামঞ্জস্যপূর্ণ হতে হবে। আকারগুলির সামঞ্জস্যপূর্ণ হওয়ার অর্থ কী তা সম্পর্কে সম্প্রচার ডকুমেন্টেশন দেখুন। একটি অপারেশনের ফলাফলের একটি আকৃতি থাকে যা দুটি ইনপুট অ্যারে সম্প্রচারের ফলাফল। এই ভেরিয়েন্টে, বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে ক্রিয়াকলাপ সমর্থিত নয় , যদি না একটি অপারেন্ড একটি স্কেলার হয়।

Atan2 এর জন্য ভিন্ন-মাত্রিক সম্প্রচার সমর্থন সহ একটি বিকল্প রূপ বিদ্যমান:

Atan2(lhs,rhs, broadcast_dimensions)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

| এলএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| আরএইচএস | XlaOp সম্পর্কে | বাম-হাতের অপারেন্ড: T ধরণের অ্যারে |

| সম্প্রচার_মাত্রা | অ্যারেস্লাইস | অপারেন্ড আকৃতির প্রতিটি মাত্রা লক্ষ্য আকৃতিতে কোন মাত্রার সাথে মিলে যায়? |

এই ধরণের অপারেশনটি বিভিন্ন র্যাঙ্কের অ্যারের মধ্যে গাণিতিক ক্রিয়াকলাপের জন্য ব্যবহার করা উচিত (যেমন একটি ভেক্টরে একটি ম্যাট্রিক্স যোগ করা)।

অতিরিক্ত broadcast_dimensions অপারেন্ড হল পূর্ণসংখ্যার একটি অংশ যা অপারেন্ড সম্প্রচারের জন্য ব্যবহৃত মাত্রা নির্দিষ্ট করে। শব্দার্থবিদ্যা সম্প্রচার পৃষ্ঠায় বিস্তারিতভাবে বর্ণনা করা হয়েছে।

StableHLO তথ্যের জন্য StableHLO - atan2 দেখুন।

ব্যাচনর্মগ্র্যাড

অ্যালগরিদমের বিস্তারিত বিবরণের জন্য XlaBuilder::BatchNormGrad এবং মূল ব্যাচ নরমালাইজেশন পেপারটিও দেখুন।

ব্যাচ আদর্শের গ্রেডিয়েন্ট গণনা করে।

BatchNormGrad(operand, scale, batch_mean, batch_var, grad_output, epsilon, feature_index)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp সম্পর্কে | n মাত্রিক অ্যারেকে স্বাভাবিক করতে হবে (x) |

scale | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে (\(\gamma\)) |

batch_mean | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে (\(\mu\)) |

batch_var | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে (\(\sigma^2\)) |

grad_output | XlaOp সম্পর্কে | BatchNormTraining এ পাস করা গ্রেডিয়েন্ট (\(\nabla y\)) |

epsilon | float | এপসিলন মান (\(\epsilon\)) |

feature_index | int64 | operand মাত্রা বৈশিষ্ট্যের সূচক |

ফিচার ডাইমেনশনের প্রতিটি ফিচারের জন্য ( feature_index হল operand ফিচার ডাইমেনশনের সূচক), অপারেশনটি অন্যান্য সমস্ত ডাইমেনশনের operand , offset এবং scale সাপেক্ষে গ্রেডিয়েন্ট গণনা করে। feature_index অবশ্যই operand ফিচার ডাইমেনশনের জন্য একটি বৈধ সূচক হতে হবে।

তিনটি গ্রেডিয়েন্ট নিম্নলিখিত সূত্র দ্বারা সংজ্ঞায়িত করা হয়েছে (একটি 4-মাত্রিক অ্যারেকে operand হিসাবে ধরে নেওয়া এবং বৈশিষ্ট্য মাত্রা সূচক l , ব্যাচ আকার m এবং স্থানিক আকার w এবং h সহ):

\[ \begin{split} c_l&= \frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \left( \nabla y_{ijkl} \frac{x_{ijkl} - \mu_l}{\sigma^2_l+\epsilon} \right) \\\\ d_l&= \frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \nabla y_{ijkl} \\\\ \nabla x_{ijkl} &= \frac{\gamma_{l} }{\sqrt{\sigma^2_{l}+\epsilon} } \left( \nabla y_{ijkl} - d_l - c_l (x_{ijkl} - \mu_{l}) \right) \\\\ \nabla \gamma_l &= \sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \left( \nabla y_{ijkl} \frac{x_{ijkl} - \mu_l}{\sqrt{\sigma^2_{l}+\epsilon} } \right) \\\\\ \nabla \beta_l &= \sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \nabla y_{ijkl} \end{split} \]

ইনপুট batch_mean এবং batch_var ব্যাচ এবং স্থানিক মাত্রা জুড়ে মুহূর্ত মান উপস্থাপন করে।

আউটপুট টাইপটি তিনটি হ্যান্ডেলের একটি টুপল:

| আউটপুট | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

grad_operand | XlaOp সম্পর্কে | ইনপুট operand সাপেক্ষে গ্রেডিয়েন্ট (\(\nabla x\)) |

grad_scale | XlaOp সম্পর্কে | ইনপুট ** scale ** এর সাপেক্ষে গ্রেডিয়েন্ট (\(\nabla\gamma\)) |

grad_offset | XlaOp সম্পর্কে | ইনপুট offset ক্ষেত্রে গ্রেডিয়েন্ট (\(\nabla\beta\)) |

StableHLO তথ্যের জন্য StableHLO - batch_norm_grad দেখুন।

ব্যাচনর্মইনফারেন্স

অ্যালগরিদমের বিস্তারিত বিবরণের জন্য XlaBuilder::BatchNormInference এবং মূল ব্যাচ নরমালাইজেশন পেপারটিও দেখুন।

ব্যাচ এবং স্থানিক মাত্রা জুড়ে একটি অ্যারেকে স্বাভাবিক করে তোলে।

BatchNormInference(operand, scale, offset, mean, variance, epsilon, feature_index)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp সম্পর্কে | n মাত্রিক অ্যারে স্বাভাবিক করতে হবে |

scale | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে |

offset | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে |

mean | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে |

variance | XlaOp সম্পর্কে | ১ মাত্রিক অ্যারে |

epsilon | float | এপসিলন মান |

feature_index | int64 | operand মাত্রা বৈশিষ্ট্যের সূচক |

ফিচার ডাইমেনশনের প্রতিটি ফিচারের জন্য ( feature_index হল operand ফিচার ডাইমেনশনের সূচক), অপারেশনটি অন্যান্য সমস্ত ডাইমেনশনের গড় এবং ভ্যারিয়েন্স গণনা করে এবং operand প্রতিটি এলিমেন্টকে স্বাভাবিক করার জন্য গড় এবং ভ্যারিয়েন্স ব্যবহার করে। feature_index অবশ্যই operand ফিচার ডাইমেনশনের জন্য একটি বৈধ ইনডেক্স হতে হবে।

BatchNormInference হল প্রতিটি ব্যাচের জন্য mean এবং variance গণনা না করে BatchNormTraining কল করার সমতুল্য। এটি আনুমানিক মান হিসাবে ইনপুট mean এবং variance ব্যবহার করে। এই অপশনের উদ্দেশ্য হল ইনফারেন্সে ল্যাটেন্সি কমানো, তাই এর নাম BatchNormInference ।

আউটপুটটি একটি n-মাত্রিক, স্বাভাবিক অ্যারে যার আকৃতি ইনপুট operand মতোই।

StableHLO তথ্যের জন্য StableHLO - batch_norm_inference দেখুন।

ব্যাচনর্মট্রেনিং

অ্যালগরিদমের বিস্তারিত বিবরণের জন্য XlaBuilder::BatchNormTraining এবং the original batch normalization paper দেখুন।

ব্যাচ এবং স্থানিক মাত্রা জুড়ে একটি অ্যারেকে স্বাভাবিক করে তোলে।

BatchNormTraining(operand, scale, offset, epsilon, feature_index)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | n মাত্রিক অ্যারেকে স্বাভাবিক করতে হবে (x) |

scale | XlaOp | ১ মাত্রিক অ্যারে (\(\gamma\)) |

offset | XlaOp | ১ মাত্রিক অ্যারে (\(\beta\)) |

epsilon | float | এপসিলন মান (\(\epsilon\)) |

feature_index | int64 | operand মাত্রা বৈশিষ্ট্যের সূচক |

ফিচার ডাইমেনশনের প্রতিটি ফিচারের জন্য ( feature_index হল operand ফিচার ডাইমেনশনের সূচক), অপারেশনটি অন্যান্য সমস্ত ডাইমেনশনের গড় এবং ভ্যারিয়েন্স গণনা করে এবং operand প্রতিটি এলিমেন্টকে স্বাভাবিক করার জন্য গড় এবং ভ্যারিয়েন্স ব্যবহার করে। feature_index অবশ্যই operand ফিচার ডাইমেনশনের জন্য একটি বৈধ ইনডেক্স হতে হবে।

operand প্রতিটি ব্যাচের জন্য অ্যালগরিদম নিম্নরূপ: \(x\) যেখানে m উপাদান রয়েছে এবং স্থানিক মাত্রার আকার w এবং h (ধরে নিচ্ছি operand একটি 4 মাত্রিক অ্যারে):

ব্যাচ গড় গণনা করে \(\mu_l\) প্রতিটি বৈশিষ্ট্যের জন্য

lবৈশিষ্ট্যের মাত্রায়:\(\mu_l=\frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h x_{ijkl}\)ব্যাচ ভ্যারিয়েন্স গণনা করে \(\sigma^2_l\): $\সিগমা^2 l=\frac{1}{mwh}\sum {i=1}^m\sum {j=1}^w\sum {k=1}^h (x_{ijkl} - \mu_l)^2$

স্বাভাবিক করে তোলে, স্কেল করে এবং পরিবর্তন করে:\(y_{ijkl}=\frac{\gamma_l(x_{ijkl}-\mu_l)}{\sqrt[2]{\sigma^2_l+\epsilon} }+\beta_l\)

এপসিলন মান, সাধারণত একটি ছোট সংখ্যা, শূন্য দিয়ে ভাগ করার ত্রুটি এড়াতে যোগ করা হয়।

আউটপুট টাইপটি তিনটি XlaOp এর একটি টুপল:

| আউটপুট | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

output | XlaOp | ইনপুট operand মতো একই আকৃতির n মাত্রিক অ্যারে (y) |

batch_mean | XlaOp | ১ মাত্রিক অ্যারে (\(\mu\)) |

batch_var | XlaOp | ১ মাত্রিক অ্যারে (\(\sigma^2\)) |

উপরের সূত্রগুলি ব্যবহার করে ব্যাচ এবং স্থানিক মাত্রা জুড়ে গণনা করা মুহূর্তগুলি হল batch_mean এবং batch_var ।

StableHLO তথ্যের জন্য StableHLO - batch_norm_training দেখুন।

বিটকাস্ট

আরও দেখুন HloInstruction::CreateBitcast ।

Bitcast HLO ডাম্পে প্রদর্শিত হতে পারে, কিন্তু এগুলি শেষ ব্যবহারকারীদের দ্বারা ম্যানুয়ালি তৈরি করার উদ্দেশ্যে নয়।

বিটকাস্টকনভার্টটাইপ

আরও দেখুন XlaBuilder::BitcastConvertType ।

TensorFlow-এর tf.bitcast এর মতোই, এটি একটি ডেটা শেপ থেকে টার্গেট শেপে একটি এলিমেন্ট-ভিত্তিক বিটকাস্ট অপারেশন সম্পাদন করে। ইনপুট এবং আউটপুট আকার অবশ্যই মিলতে হবে: যেমন s32 এলিমেন্টগুলি বিটকাস্ট রুটিনের মাধ্যমে f32 এলিমেন্টে পরিণত হয়, এবং একটি s32 এলিমেন্ট চারটি s8 এলিমেন্টে পরিণত হয়। বিটকাস্ট একটি নিম্ন-স্তরের কাস্ট হিসাবে বাস্তবায়িত হয়, তাই বিভিন্ন ফ্লোটিং-পয়েন্ট উপস্থাপনা সহ মেশিনগুলি বিভিন্ন ফলাফল দেবে।

BitcastConvertType(operand, new_element_type)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ডি-এর সাথে টাইপ টি-এর অ্যারে |

new_element_type | PrimitiveType | টাইপ ইউ |

অপারেন্ডের মাত্রা এবং লক্ষ্য আকৃতি অবশ্যই মিলতে হবে, শেষ মাত্রাটি বাদ দিলে যা রূপান্তরের আগে এবং পরে আদিম আকারের অনুপাত দ্বারা পরিবর্তিত হবে।

উৎস এবং গন্তব্য উপাদানের ধরণগুলি টিপল হওয়া উচিত নয়।

StableHLO তথ্যের জন্য StableHLO - bitcast_convert দেখুন।

বিটকাস্ট-বিভিন্ন প্রস্থের আদিম ধরণের রূপান্তর

BitcastConvert HLO নির্দেশনা সেই ক্ষেত্রে সমর্থন করে যেখানে আউটপুট উপাদান টাইপ T' এর আকার ইনপুট উপাদান T এর আকারের সমান নয়। যেহেতু পুরো অপারেশনটি ধারণাগতভাবে একটি বিটকাস্ট এবং অন্তর্নিহিত বাইট পরিবর্তন করে না, তাই আউটপুট উপাদানের আকৃতি পরিবর্তন করতে হবে। B = sizeof(T), B' = sizeof(T') এর জন্য, দুটি সম্ভাব্য ক্ষেত্রে রয়েছে।

প্রথমত, যখন B > B' , আউটপুট আকৃতিটি B/B' আকারের একটি নতুন ক্ষুদ্রতম মাত্রা পায়। উদাহরণস্বরূপ:

f16[10,2]{1,0} %output = f16[10,2]{1,0} bitcast-convert(f32[10]{0} %input)

কার্যকর স্কেলারের ক্ষেত্রেও নিয়মটি একই থাকে:

f16[2]{0} %output = f16[2]{0} bitcast-convert(f32[] %input)

বিকল্পভাবে, B' > B এর জন্য নির্দেশের জন্য ইনপুট আকৃতির শেষ লজিক্যাল মাত্রা B'/B এর সমান হওয়া প্রয়োজন, এবং রূপান্তরের সময় এই মাত্রাটি বাদ দেওয়া হয়:

f32[10]{0} %output = f32[10]{0} bitcast-convert(f16[10,2]{1,0} %input)

মনে রাখবেন যে বিভিন্ন বিটউইথের মধ্যে রূপান্তরগুলি এলিমেন্টওয়াইজ নয়।

সম্প্রচার

আরও দেখুন XlaBuilder::Broadcast ।

অ্যারেতে থাকা ডেটা ডুপ্লিকেট করে একটি অ্যারেতে মাত্রা যোগ করে।

Broadcast(operand, broadcast_sizes)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ডুপ্লিকেট করার জন্য অ্যারে |

broadcast_sizes | ArraySlice<int64> | নতুন মাত্রার আকার |

নতুন মাত্রাগুলি বাম দিকে সন্নিবেশ করা হয়েছে, অর্থাৎ যদি broadcast_sizes মান {a0, ..., aN} থাকে এবং অপারেন্ড আকৃতির মাত্রা {b0, ..., bM} থাকে তাহলে আউটপুটের আকৃতির মাত্রা {a0, ..., aN, b0, ..., bM} থাকে।

অপারেন্ডের কপিগুলিতে নতুন মাত্রা সূচক, অর্থাৎ

output[i0, ..., iN, j0, ..., jM] = operand[j0, ..., jM]

উদাহরণস্বরূপ, যদি operand একটি স্কেলার f32 হয় যার মান 2.0f , এবং broadcast_sizes {2, 3} হয়, তাহলে ফলাফলটি f32[2, 3] আকৃতির একটি অ্যারে হবে এবং ফলাফলের সমস্ত মান 2.0f হবে।

StableHLO তথ্যের জন্য StableHLO - সম্প্রচার দেখুন।

ব্রডকাস্টইনডিম

আরও দেখুন XlaBuilder::BroadcastInDim ।

অ্যারের ডেটা ডুপ্লিকেট করে একটি অ্যারের আকার এবং মাত্রার সংখ্যা প্রসারিত করে।

BroadcastInDim(operand, out_dim_size, broadcast_dimensions)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ডুপ্লিকেট করার জন্য অ্যারে |

out_dim_size | ArraySlice<int64> | লক্ষ্য আকৃতির মাত্রার আকার |

broadcast_dimensions | ArraySlice<int64> | অপারেন্ড আকৃতির প্রতিটি মাত্রা লক্ষ্য আকৃতিতে কোন মাত্রার সাথে মিলে যায়? |

ব্রডকাস্টের মতোই, তবে সাইজ ১ ব্যবহার করে যেকোনো জায়গায় মাত্রা যোগ করা এবং বিদ্যমান মাত্রা সম্প্রসারণের অনুমতি দেওয়া হয়।

operand out_dim_size দ্বারা বর্ণিত আকারে সম্প্রচারিত হয়। broadcast_dimensions operand মাত্রাগুলিকে লক্ষ্য আকৃতির মাত্রার সাথে ম্যাপ করে, অর্থাৎ অপারেন্ডের i'তম মাত্রা আউটপুট আকৃতির broadcast_dimension[i]'তম মাত্রার সাথে ম্যাপ করা হয়। operand মাত্রাগুলির আকার 1 হতে হবে অথবা আউটপুট আকৃতিতে ম্যাপ করা মাত্রার সমান হতে হবে। বাকি মাত্রাগুলি আকার 1 এর মাত্রা দিয়ে পূর্ণ করা হয়। ডিজেনারেট-ডাইমেনশন ব্রডকাস্টিং তারপর আউটপুট আকৃতিতে পৌঁছানোর জন্য এই ডিজেনারেট মাত্রাগুলি বরাবর সম্প্রচার করে। শব্দার্থবিদ্যা সম্প্রচার পৃষ্ঠায় বিস্তারিতভাবে বর্ণনা করা হয়েছে।

কল করুন

আরও দেখুন XlaBuilder::Call

প্রদত্ত যুক্তিগুলির সাথে একটি গণনা আহ্বান করে।

Call(computation, operands...)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

computation | XlaComputation | T_0, T_1, ..., T_{N-1} -> S ধরণের গণনা, যা ইচ্ছাকৃত ধরণের N প্যারামিটার সহ |

operands | N XlaOp s এর ক্রম | ইচ্ছাকৃত ধরণের N আর্গুমেন্ট |

operands অ্যারিটি এবং প্রকারগুলি computation প্যারামিটারগুলির সাথে মিলতে হবে। এতে কোনও operands না থাকার অনুমতি রয়েছে।

কম্পোজিটকল

আরও দেখুন XlaBuilder::CompositeCall ।

অন্যান্য StableHLO অপারেশনের সমন্বয়ে গঠিত (রচিত) একটি অপারেশনকে ধারণ করে, ইনপুট এবং composite_attributes গ্রহণ করে এবং ফলাফল তৈরি করে। op এর শব্দার্থবিদ্যা decomposition বৈশিষ্ট্য দ্বারা বাস্তবায়িত হয়। প্রোগ্রাম শব্দার্থবিদ্যা পরিবর্তন না করেই composite op কে এর decomposition দিয়ে প্রতিস্থাপন করা যেতে পারে। যেসব ক্ষেত্রে decomposition ইনলাইন করা একই op শব্দার্থবিদ্যা প্রদান করে না, custom_call ব্যবহার করা পছন্দ করুন।

একটি কম্পোজিট এর শব্দার্থবিদ্যা পরিবর্তন হলে বোঝাতে সংস্করণ ক্ষেত্র (ডিফল্ট 0) ব্যবহার করা হয়।

এই অপশনটি kCall হিসেবে is_composite=true অ্যাট্রিবিউট সহ বাস্তবায়িত হয়। decomposition ক্ষেত্রটি computation অ্যাট্রিবিউট দ্বারা নির্দিষ্ট করা হয়। ফ্রন্টএন্ড অ্যাট্রিবিউটগুলি composite.

উদাহরণ কম্পোজিট কল অপ:

f32[] call(f32[] %cst), to_apply=%computation, is_composite=true,

frontend_attributes = {

composite.name="foo.bar",

composite.attributes={n = 1 : i32, tensor = dense<1> : tensor<i32>},

composite.version="1"

}

CompositeCall(computation, operands..., name, attributes, version)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

computation | XlaComputation | T_0, T_1, ..., T_{N-1} -> S ধরণের গণনা, যা ইচ্ছাকৃত ধরণের N প্যারামিটার সহ |

operands | N XlaOp s এর ক্রম | মানের বৈচিত্র্যময় সংখ্যা |

name | string | কম্পোজিটটির নাম |

attributes | ঐচ্ছিক string | ঐচ্ছিক স্ট্রিংফাইড অ্যাট্রিবিউট অভিধান |

version | ঐচ্ছিক int64 | কম্পোজিট অপের শব্দার্থবিদ্যার সংস্করণ আপডেটের সংখ্যা |

একটি অপের decomposition নাম কোন ফিল্ড নয়, বরং এটি একটি to_apply অ্যাট্রিবিউট হিসেবে প্রদর্শিত হয় যা নিম্ন-স্তরের বাস্তবায়ন ধারণকারী ফাংশনের দিকে নির্দেশ করে, অর্থাৎ to_apply=%funcname

কম্পোজিট এবং পচন সম্পর্কে আরও তথ্য StableHLO স্পেসিফিকেশনে পাওয়া যাবে।

সিবিআরটি

আরও দেখুন XlaBuilder::Cbrt ।

উপাদান-ভিত্তিক ঘনমূলের ক্রিয়াকলাপ x -> cbrt(x) ।

Cbrt(operand)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

Cbrt ঐচ্ছিক result_accuracy আর্গুমেন্টকেও সমর্থন করে:

Cbrt(operand, result_accuracy)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

result_accuracy | ঐচ্ছিক ResultAccuracy | একাধিক বাস্তবায়ন সহ ইউনারি অপশনের জন্য ব্যবহারকারী যে ধরণের নির্ভুলতার অনুরোধ করতে পারেন |

result_accuracy সম্পর্কে আরও তথ্যের জন্য ফলাফলের নির্ভুলতা দেখুন।

StableHLO তথ্যের জন্য StableHLO - cbrt দেখুন।

সিল

আরও দেখুন XlaBuilder::Ceil ।

উপাদান-ভিত্তিক সিলিং x -> ⌈x⌉ ।

Ceil(operand)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

StableHLO তথ্যের জন্য StableHLO - ceil দেখুন।

চোলেস্কি

আরও দেখুন XlaBuilder::Cholesky ।

প্রতিসম (হার্মিটিয়ান) ধনাত্মক নির্দিষ্ট ম্যাট্রিক্সের একটি ব্যাচের চোলেস্কি পচন গণনা করে।

Cholesky(a, lower)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

a | XlaOp | > 2 মাত্রা সহ একটি জটিল বা ভাসমান-বিন্দু ধরণের অ্যারে। |

lower | bool | a এর উপরের বা নীচের ত্রিভুজ ব্যবহার করবেন কিনা। |

যদি lower true হয়, তাহলে নিম্ন-ত্রিভুজাকার ম্যাট্রিক্স l গণনা করে যাতে $a = l . l^T$। যদি lower false হয়, তাহলে ঊর্ধ্ব-ত্রিভুজাকার ম্যাট্রিক্স u গণনা করে যাতে\(a = u^T . u\).

ইনপুট ডেটা শুধুমাত্র a এর নিম্ন/উপরের ত্রিভুজ থেকে পঠিত হয়, যা lower এর মানের উপর নির্ভর করে। অন্য ত্রিভুজ থেকে মান উপেক্ষা করা হয়। আউটপুট ডেটা একই ত্রিভুজে ফেরত পাঠানো হয়; অন্য ত্রিভুজের মানগুলি বাস্তবায়ন-সংজ্ঞায়িত এবং যেকোনো কিছু হতে পারে।

যদি a 2টির বেশি মাত্রা থাকে, তাহলে a ম্যাট্রিক্সের একটি ব্যাচ হিসেবে বিবেচনা করা হয়, যেখানে গৌণ 2 মাত্রা ছাড়া বাকি সবগুলি ব্যাচ মাত্রা।

যদি a প্রতিসম (হারমিশিয়ান) ধনাত্মক নির্দিষ্ট না হয়, তাহলে ফলাফলটি বাস্তবায়ন-সংজ্ঞায়িত।

StableHLO তথ্যের জন্য StableHLO - cholesky দেখুন।

ক্ল্যাম্প

আরও দেখুন XlaBuilder::Clamp ।

একটি অপারেন্ডকে সর্বনিম্ন এবং সর্বোচ্চ মানের মধ্যে ক্ল্যাম্প করে।

Clamp(min, operand, max)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

min | XlaOp | T ধরণের অ্যারে |

operand | XlaOp | T ধরণের অ্যারে |

max | XlaOp | T ধরণের অ্যারে |

একটি অপারেন্ড এবং সর্বনিম্ন এবং সর্বোচ্চ মান দেওয়া হলে, অপারেন্ডটি সর্বনিম্ন এবং সর্বোচ্চের মধ্যে থাকলে তা ফেরত দেয়, অন্যথায় যদি অপারেন্ডটি এই পরিসরের নীচে থাকে তবে সর্বনিম্ন মান ফেরত দেয় অথবা যদি অপারেন্ডটি এই পরিসরের উপরে থাকে তবে সর্বোচ্চ মান ফেরত দেয়। অর্থাৎ, clamp(a, x, b) = min(max(a, x), b) ।

তিনটি অ্যারে অবশ্যই একই আকৃতির হতে হবে। বিকল্পভাবে, সম্প্রচারের একটি সীমাবদ্ধ রূপ হিসেবে, min এবং/অথবা max T ধরণের একটি স্কেলার হতে পারে।

স্কেলার min এবং max সহ উদাহরণ:

let operand: s32[3] = {-1, 5, 9};

let min: s32 = 0;

let max: s32 = 6;

==>

Clamp(min, operand, max) = s32[3]{0, 5, 6};

StableHLO তথ্যের জন্য StableHLO - ক্ল্যাম্প দেখুন।

সঙ্কুচিত করুন

আরও দেখুন XlaBuilder::Collapse . এবং tf.reshape অপারেশন।

একটি অ্যারের মাত্রাগুলিকে এক মাত্রায় সঙ্কুচিত করে।

Collapse(operand, dimensions)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | T ধরণের অ্যারে |

dimensions | int64 ভেক্টর | T এর মাত্রার ধারাবাহিক উপসেট, ক্রমানুসারে। |

Collapse অপারেন্ডের মাত্রার প্রদত্ত উপসেটকে একটি একক মাত্রা দ্বারা প্রতিস্থাপন করে। ইনপুট আর্গুমেন্টগুলি হল T ধরণের একটি ইচ্ছাকৃত অ্যারে এবং মাত্রা সূচকগুলির একটি কম্পাইল-টাইম-কনস্ট্যান্ট ভেক্টর। মাত্রা সূচকগুলি অবশ্যই একটি ইন-অর্ডার (নিম্ন থেকে উচ্চ মাত্রা সংখ্যা), T এর মাত্রার ধারাবাহিক উপসেট হতে হবে। সুতরাং, {0, 1, 2}, {0, 1}, অথবা {1, 2} সকল বৈধ মাত্রা সেট, কিন্তু {1, 0} অথবা {0, 2} নয়। এগুলি একটি নতুন মাত্রা দ্বারা প্রতিস্থাপিত হয়, যে মাত্রা ক্রমগুলি তারা প্রতিস্থাপন করে তার একই অবস্থানে, নতুন মাত্রার আকার মূল মাত্রার আকারের গুণফলের সমান। dimensions সর্বনিম্ন মাত্রা সংখ্যা হল লুপ নেস্টে সবচেয়ে ধীরতম পরিবর্তনশীল মাত্রা (সবচেয়ে প্রধান) যা এই মাত্রাগুলিকে ভেঙে দেয়, এবং সর্বোচ্চ মাত্রা সংখ্যা হল দ্রুততম পরিবর্তনশীল (সবচেয়ে ছোট)। আরও সাধারণ ধীর পরিবর্তনশীল ক্রম প্রয়োজন হলে tf.reshape অপারেটরটি দেখুন।

উদাহরণস্বরূপ, ধরুন v হল 24টি উপাদানের একটি অ্যারে:

let v = f32[4x2x3] { { {10, 11, 12}, {15, 16, 17} },

{ {20, 21, 22}, {25, 26, 27} },

{ {30, 31, 32}, {35, 36, 37} },

{ {40, 41, 42}, {45, 46, 47} } };

// Collapse to a single dimension, leaving one dimension.

let v012 = Collapse(v, {0,1,2});

then v012 == f32[24] {10, 11, 12, 15, 16, 17,

20, 21, 22, 25, 26, 27,

30, 31, 32, 35, 36, 37,

40, 41, 42, 45, 46, 47};

// Collapse the two lower dimensions, leaving two dimensions.

let v01 = Collapse(v, {0,1});

then v01 == f32[4x6] { {10, 11, 12, 15, 16, 17},

{20, 21, 22, 25, 26, 27},

{30, 31, 32, 35, 36, 37},

{40, 41, 42, 45, 46, 47} };

// Collapse the two higher dimensions, leaving two dimensions.

let v12 = Collapse(v, {1,2});

then v12 == f32[8x3] { {10, 11, 12},

{15, 16, 17},

{20, 21, 22},

{25, 26, 27},

{30, 31, 32},

{35, 36, 37},

{40, 41, 42},

{45, 46, 47} };

ক্লজ

আরও দেখুন XlaBuilder::Clz ।

উপাদান অনুসারে অগ্রবর্তী শূন্য গণনা করুন।

Clz(operand)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

কালেক্টিভব্রডকাস্ট

আরও দেখুন XlaBuilder::CollectiveBroadcast ।

রেপ্লিকা জুড়ে ডেটা সম্প্রচার করে। প্রতিটি গ্রুপের প্রথম রেপ্লিকা আইডি থেকে একই গ্রুপের অন্যান্য আইডিতে ডেটা পাঠানো হয়। যদি একটি রেপ্লিকা আইডি কোনও রেপ্লিকা গ্রুপে না থাকে, তাহলে সেই রেপ্লিকার আউটপুট হল 0(s) shape একটি টেনসর।

CollectiveBroadcast(operand, replica_groups, channel_id)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | ফাংশনের অপারেন্ড |

replica_groups | ReplicaGroup ভেক্টর | প্রতিটি গ্রুপে রেপ্লিকা আইডির একটি তালিকা থাকে |

channel_id | ঐচ্ছিক ChannelHandle | প্রতিটি সেন্ড/রেকভি জোড়ার জন্য অনন্য শনাক্তকারী |

StableHLO তথ্যের জন্য StableHLO - collective_broadcast দেখুন।

CollectivePermute সম্পর্কে

আরও দেখুন XlaBuilder::CollectivePermute ।

CollectivePermute হলো একটি যৌথ অপারেশন যা প্রতিলিপি জুড়ে ডেটা প্রেরণ এবং গ্রহণ করে।

CollectivePermute(operand, source_target_pairs, channel_id, inplace)

| যুক্তি | আদর্শ | শব্দার্থবিদ্যা |

|---|---|---|

operand | XlaOp | n মাত্রিক ইনপুট অ্যারে |

source_target_pairs | <int64, int64> ভেক্টর | (source_replica_id, target_replica_id) জোড়ার একটি তালিকা। প্রতিটি জোড়ার জন্য, অপারেন্ডটি সোর্স রেপ্লিকা থেকে টার্গেট রেপ্লিকাতে পাঠানো হয়। |

channel_id | ঐচ্ছিক ChannelHandle | ক্রস-মডিউল যোগাযোগের জন্য ঐচ্ছিক চ্যানেল আইডি |

inplace | ঐচ্ছিক bool | স্থানে বিন্যাস করা উচিত কিনা তা চিহ্নিত করুন |

মনে রাখবেন যে source_target_pairs এর উপর নিম্নলিখিত বিধিনিষেধ রয়েছে:

- যেকোনো দুটি জোড়ার একই লক্ষ্য প্রতিরূপ আইডি থাকা উচিত নয়, এবং তাদের একই উৎস প্রতিরূপ আইডি থাকা উচিত নয়।

- যদি কোনও জোড়ায় একটি রেপ্লিকা আইডি লক্ষ্যবস্তু না হয়, তাহলে সেই রেপ্লিকার আউটপুটটি ইনপুটের মতো একই আকৃতির 0(s) সমন্বিত একটি টেনসর হবে।

The API of CollectivePermute operation is internally decomposed into 2 HLO instructions ( CollectivePermuteStart and CollectivePermuteDone ).

See also HloInstruction::CreateCollectivePermuteStart .

CollectivePermuteStart and CollectivePermuteDone serve as primitives in HLO. These ops may appear in HLO dumps, but they are not intended to be constructed manually by end users.

For StableHLO information see StableHLO - collective_permute .

তুলনা করা

See also XlaBuilder::Compare .

Performs element-wise comparison of lhs and rhs of the following:

সমীকরণ

See also XlaBuilder::Eq .

Performs element-wise equal-to comparison of lhs and rhs .

\(lhs = rhs\)

Eq(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Eq:

Eq(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

Support a total order over the floating point numbers exists for Eq, by enforcing:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

EqTotalOrder(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

For StableHLO information see StableHLO - compare .

নে

See also XlaBuilder::Ne .

Performs element-wise not equal-to comparison of lhs and rhs .

\(lhs != rhs\)

Ne(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Ne:

Ne(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

Support a total order over the floating point numbers exists for Ne, by enforcing:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

NeTotalOrder(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

For StableHLO information see StableHLO - compare .

জিই

See also XlaBuilder::Ge .

Performs element-wise greater-or-equal-than comparison of lhs and rhs .

\(lhs >= rhs\)

Ge(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Ge:

Ge(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

Support a total order over the floating point numbers exists for Gt, by enforcing:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

GtTotalOrder(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

For StableHLO information see StableHLO - compare .

জিটি

See also XlaBuilder::Gt .

Performs element-wise greater-than comparison of lhs and rhs .

\(lhs > rhs\)

Gt(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Gt:

Gt(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

For StableHLO information see StableHLO - compare .

Le

See also XlaBuilder::Le .

Performs element-wise less-or-equal-than comparison of lhs and rhs .

\(lhs <= rhs\)

Le(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Le:

Le(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

Support a total order over the floating point numbers exists for Le, by enforcing:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

LeTotalOrder(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

For StableHLO information see StableHLO - compare .

Lt

See also XlaBuilder::Lt .

Performs element-wise less-than comparison of lhs and rhs .

\(lhs < rhs\)

Lt(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Lt:

Lt(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

Support a total order over the floating point numbers exists for Lt, by enforcing:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

LtTotalOrder(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

For StableHLO information see StableHLO - compare .

Complex

See also XlaBuilder::Complex .

Performs element-wise conversion to a complex value from a pair of real and imaginary values, lhs and rhs .

Complex(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Complex:

Complex(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

For StableHLO information see StableHLO - complex .

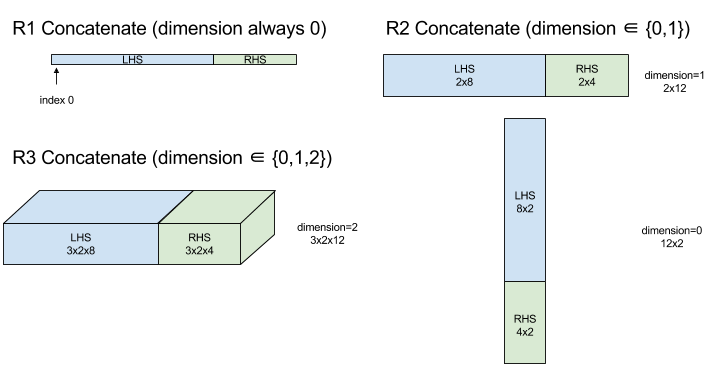

ConcatInDim (Concatenate)

See also XlaBuilder::ConcatInDim .

Concatenate composes an array from multiple array operands. The array has the same number of dimensions as each of the input array operands (which must have the same number of dimensions as each other) and contains the arguments in the order that they were specified.

Concatenate(operands..., dimension)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operands | sequence of N XlaOp | N arrays of type T with dimensions [L0, L1, ...]. Requires N >= 1. |

dimension | int64 | A value in the interval [0, N) that names the dimension to be concatenated between the operands . |

With the exception of dimension all dimensions must be the same. This is because XLA does not support "ragged" arrays. Also note that 0-dimensional values cannot be concatenated (as it's impossible to name the dimension along which the concatenation occurs).

1-dimensional example:

Concat({ {2, 3}, {4, 5}, {6, 7} }, 0)

//Output: {2, 3, 4, 5, 6, 7}

2-dimensional example:

let a = { {1, 2},

{3, 4},

{5, 6} };

let b = { {7, 8} };

Concat({a, b}, 0)

//Output: { {1, 2},

// {3, 4},

// {5, 6},

// {7, 8} }

Diagram:

For StableHLO information see StableHLO - concatenate .

Conditional

See also XlaBuilder::Conditional .

Conditional(predicate, true_operand, true_computation, false_operand, false_computation)

| Arguments | আদর্শ | Semantics |

|---|---|---|

predicate | XlaOp | Scalar of type PRED |

true_operand | XlaOp | Argument of type \(T_0\) |

true_computation | XlaComputation | XlaComputation of type \(T_0 \to S\) |

false_operand | XlaOp | Argument of type \(T_1\) |

false_computation | XlaComputation | XlaComputation of type \(T_1 \to S\) |

Executes true_computation if predicate is true , false_computation if predicate is false , and returns the result.

The true_computation must take in a single argument of type \(T_0\) and will be invoked with true_operand which must be of the same type. The false_computation must take in a single argument of type \(T_1\) and will be invoked with false_operand which must be of the same type. The type of the returned value of true_computation and false_computation must be the same.

Note that only one of true_computation and false_computation will be executed depending on the value of predicate .

Conditional(branch_index, branch_computations, branch_operands)

| Arguments | আদর্শ | Semantics |

|---|---|---|

branch_index | XlaOp | Scalar of type S32 |

branch_computations | sequence of N XlaComputation | XlaComputations of type \(T_0 \to S , T_1 \to S , ..., T_{N-1} \to S\) |

branch_operands | sequence of N XlaOp | Arguments of type \(T_0 , T_1 , ..., T_{N-1}\) |

Executes branch_computations[branch_index] , and returns the result. If branch_index is an S32 which is < 0 or >= N, then branch_computations[N-1] is executed as the default branch.

Each branch_computations[b] must take in a single argument of type \(T_b\) and will be invoked with branch_operands[b] which must be of the same type. The type of the returned value of each branch_computations[b] must be the same.

Note that only one of the branch_computations will be executed depending on the value of branch_index .

For StableHLO information see StableHLO - if .

ধ্রুবক

See also XlaBuilder::ConstantLiteral .

Produces an output from a constant literal .

Constant(literal)

| Arguments | আদর্শ | Semantics |

|---|---|---|

literal | LiteralSlice | constant view of an existing Literal |

For StableHLO information see StableHLO - constant .

ConvertElementType

See also XlaBuilder::ConvertElementType .

Similar to an element-wise static_cast in C++, ConvertElementType performs an element-wise conversion operation from a data shape to a target shape. The dimensions must match, and the conversion is an element-wise one; eg s32 elements become f32 elements via an s32 -to- f32 conversion routine.

ConvertElementType(operand, new_element_type)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operand | XlaOp | array of type T with dims D |

new_element_type | PrimitiveType | type U |

The dimensions of the operand and the target shape must match. The source and destination element types must not be tuples.

A conversion such as T=s32 to U=f32 will perform a normalizing int-to-float conversion routine such as round-to-nearest-even.

let a: s32[3] = {0, 1, 2};

let b: f32[3] = convert(a, f32);

then b == f32[3]{0.0, 1.0, 2.0}

For StableHLO information see StableHLO - convert .

Conv (Convolution)

See also XlaBuilder::Conv .

Computes a convolution of the kind used in neural networks. Here, a convolution can be thought of as a n-dimensional window moving across a n-dimensional base area and a computation is performed for each possible position of the window.

Conv Enqueues a convolution instruction onto the computation, which uses the default convolution dimension numbers with no dilation.

The padding is specified in a short-hand way as either SAME or VALID. SAME padding pads the input ( lhs ) with zeroes so that the output has the same shape as the input when not taking striding into account. VALID padding simply means no padding.

Conv(lhs, rhs, window_strides, padding, feature_group_count, batch_group_count, precision_config, preferred_element_type)

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | (n+2)-dimensional array of inputs |

rhs | XlaOp | (n+2)-dimensional array of kernel weights |

window_strides | ArraySlice<int64> | nd array of kernel strides |

padding | Padding | enum of padding |

feature_group_count | int64 | the number of feature groups |

batch_group_count | int64 | the number of batch groups |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

Increasing levels of controls are available for Conv :

Let n be the number of spatial dimensions. The lhs argument is an (n+2)-dimensional array describing the base area. This is called the input, even though of course the rhs is also an input. In a neural network, these are the input activations. The n+2 dimensions are, in this order:

-

batch: Each coordinate in this dimension represents an independent input for which convolution is carried out. -

z/depth/features: Each (y,x) position in the base area has a vector associated to it, which goes into this dimension. -

spatial_dims: Describes thenspatial dimensions that define the base area that the window moves across.

The rhs argument is an (n+2)-dimensional array describing the convolutional filter/kernel/window. The dimensions are, in this order:

-

output-z: Thezdimension of the output. -

input-z: The size of this dimension timesfeature_group_countshould equal the size of thezdimension in lhs. -

spatial_dims: Describes thenspatial dimensions that define the nd window that moves across the base area.

The window_strides argument specifies the stride of the convolutional window in the spatial dimensions. For example, if the stride in the first spatial dimension is 3, then the window can only be placed at coordinates where the first spatial index is divisible by 3.

The padding argument specifies the amount of zero padding to be applied to the base area. The amount of padding can be negative -- the absolute value of negative padding indicates the number of elements to remove from the specified dimension before doing the convolution. padding[0] specifies the padding for dimension y and padding[1] specifies the padding for dimension x . Each pair has the low padding as the first element and the high padding as the second element. The low padding is applied in the direction of lower indices while the high padding is applied in the direction of higher indices. For example, if padding[1] is (2,3) then there will be a padding by 2 zeroes on the left and by 3 zeroes on the right in the second spatial dimension. Using padding is equivalent to inserting those same zero values into the input ( lhs ) before doing the convolution.

The lhs_dilation and rhs_dilation arguments specify the dilation factor to be applied to the lhs and rhs, respectively, in each spatial dimension. If the dilation factor in a spatial dimension is d, then d-1 holes are implicitly placed between each of the entries in that dimension, increasing the size of the array. The holes are filled with a no-op value, which for convolution means zeroes.

Dilation of the rhs is also called atrous convolution. For more details, see tf.nn.atrous_conv2d . Dilation of the lhs is also called transposed convolution. For more details, see tf.nn.conv2d_transpose .

The feature_group_count argument (default value 1) can be used for grouped convolutions. feature_group_count needs to be a divisor of both the input and the output feature dimension. If feature_group_count is greater than 1, it means that conceptually the input and output feature dimension and the rhs output feature dimension are split evenly into many feature_group_count groups, each group consisting of a consecutive subsequence of features. The input feature dimension of rhs needs to be equal to the lhs input feature dimension divided by feature_group_count (so it already has the size of a group of input features). The i-th groups are used together to compute feature_group_count for many separate convolutions. The results of these convolutions are concatenated together in the output feature dimension.

For depthwise convolution the feature_group_count argument would be set to the input feature dimension, and the filter would be reshaped from [filter_height, filter_width, in_channels, channel_multiplier] to [filter_height, filter_width, 1, in_channels * channel_multiplier] . For more details, see tf.nn.depthwise_conv2d .

The batch_group_count (default value 1) argument can be used for grouped filters during backpropagation. batch_group_count needs to be a divisor of the size of the lhs (input) batch dimension. If batch_group_count is greater than 1, it means that the output batch dimension should be of size input batch / batch_group_count . The batch_group_count must be a divisor of the output feature size.

The output shape has these dimensions, in this order:

-

batch: The size of this dimension timesbatch_group_countshould equal the size of thebatchdimension in lhs. -

z: Same size asoutput-zon the kernel (rhs). -

spatial_dims: One value for each valid placement of the convolutional window.

The figure above shows how the batch_group_count field works. Effectively, we slice each lhs batch into batch_group_count groups, and do the same for the output features. Then, for each of these groups we do pairwise convolutions and concatenate the output along the output feature dimension. The operational semantics of all the other dimensions (feature and spatial) remain the same.

The valid placements of the convolutional window are determined by the strides and the size of the base area after padding.

To describe what a convolution does, consider a 2d convolution, and pick some fixed batch , z , y , x coordinates in the output. Then (y,x) is a position of a corner of the window within the base area (eg the upper left corner, depending on how you interpret the spatial dimensions). We now have a 2d window, taken from the base area, where each 2d point is associated to a 1d vector, so we get a 3d box. From the convolutional kernel, since we fixed the output coordinate z , we also have a 3d box. The two boxes have the same dimensions, so we can take the sum of the element-wise products between the two boxes (similar to a dot product). That is the output value.

Note that if output-z is eg, 5, then each position of the window produces 5 values in the output into the z dimension of the output. These values differ in what part of the convolutional kernel is used - there is a separate 3d box of values used for each output-z coordinate. So you could think of it as 5 separate convolutions with a different filter for each of them.

Here is pseudo-code for a 2d convolution with padding and striding:

for (b, oz, oy, ox) { // output coordinates

value = 0;

for (iz, ky, kx) { // kernel coordinates and input z

iy = oy*stride_y + ky - pad_low_y;

ix = ox*stride_x + kx - pad_low_x;

if ((iy, ix) inside the base area considered without padding) {

value += input(b, iz, iy, ix) * kernel(oz, iz, ky, kx);

}

}

output(b, oz, oy, ox) = value;

}

precision_config is used to indicate the precision configuration. The level dictates whether hardware should attempt to generate more machine code instructions to provide more accurate dtype emulation when needed (ie emulating f32 on a TPU that only supports bf16 matmuls). Values may be DEFAULT , HIGH , HIGHEST . Additional details in the MXU sections .

preferred_element_type is a scalar element of higher/lower precision output types used for accumulation. preferred_element_type recommends the accumulation type for the given operation, however it is not guaranteed. This allows for some hardware backends to instead accumulate in a different type and convert to the preferred output type.

For StableHLO information see StableHLO - convolution .

ConvWithGeneralPadding

See also XlaBuilder::ConvWithGeneralPadding .

ConvWithGeneralPadding(lhs, rhs, window_strides, padding, feature_group_count, batch_group_count, precision_config, preferred_element_type)

Same as Conv where padding configuration is explicit.

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | (n+2)-dimensional array of inputs |

rhs | XlaOp | (n+2)-dimensional array of kernel weights |

window_strides | ArraySlice<int64> | nd array of kernel strides |

padding | ArraySlice< pair<int64,int64>> | nd array of (low, high) padding |

feature_group_count | int64 | the number of feature groups |

batch_group_count | int64 | the number of batch groups |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

ConvWithGeneralDimensions

See also XlaBuilder::ConvWithGeneralDimensions .

ConvWithGeneralDimensions(lhs, rhs, window_strides, padding, dimension_numbers, feature_group_count, batch_group_count, precision_config, preferred_element_type)

Same as Conv where dimension numbers are explicit.

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | (n+2)-dimensional array of inputs |

rhs | XlaOp | (n+2)-dimensional array of kernel weights |

window_strides | ArraySlice<int64> | nd array of kernel strides |

padding | Padding | enum of padding |

dimension_numbers | ConvolutionDimensionNumbers | the number of dimensions |

feature_group_count | int64 | the number of feature groups |

batch_group_count | int64 | the number of batch groups |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

ConvGeneral

See also XlaBuilder::ConvGeneral .

ConvGeneral(lhs, rhs, window_strides, padding, dimension_numbers, feature_group_count, batch_group_count, precision_config, preferred_element_type)

Same as Conv where dimension numbers and padding configuration is explicit

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | (n+2)-dimensional array of inputs |

rhs | XlaOp | (n+2)-dimensional array of kernel weights |

window_strides | ArraySlice<int64> | nd array of kernel strides |

padding | ArraySlice< pair<int64,int64>> | nd array of (low, high) padding |

dimension_numbers | ConvolutionDimensionNumbers | the number of dimensions |

feature_group_count | int64 | the number of feature groups |

batch_group_count | int64 | the number of batch groups |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

ConvGeneralDilated

See also XlaBuilder::ConvGeneralDilated .

ConvGeneralDilated(lhs, rhs, window_strides, padding, lhs_dilation, rhs_dilation, dimension_numbers, feature_group_count, batch_group_count, precision_config, preferred_element_type, window_reversal)

Same as Conv where padding configuration, dilation factors, and dimension numbers are explicit.

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | (n+2)-dimensional array of inputs |

rhs | XlaOp | (n+2)-dimensional array of kernel weights |

window_strides | ArraySlice<int64> | nd array of kernel strides |

padding | ArraySlice< pair<int64,int64>> | nd array of (low, high) padding |

lhs_dilation | ArraySlice<int64> | nd lhs dilation factor array |

rhs_dilation | ArraySlice<int64> | nd rhs dilation factor array |

dimension_numbers | ConvolutionDimensionNumbers | the number of dimensions |

feature_group_count | int64 | the number of feature groups |

batch_group_count | int64 | the number of batch groups |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

window_reversal | optional vector<bool> | flag used to logically reverse dimension before applying the convolution |

কপি

See also HloInstruction::CreateCopyStart .

Copy is internally decomposed into 2 HLO instructions CopyStart and CopyDone . Copy along with CopyStart and CopyDone serve as primitives in HLO. These ops may appear in HLO dumps, but they are not intended to be constructed manually by end users.

Cos

See also XlaBuilder::Cos .

Element-wise cosine x -> cos(x) .

Cos(operand)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operand | XlaOp | The operand to the function |

Cos also supports the optional result_accuracy argument:

Cos(operand, result_accuracy)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operand | XlaOp | The operand to the function |

result_accuracy | optional ResultAccuracy | The types of accuracy the user can request for unary ops with multiple implementations |

For more information on result_accuracy see Result Accuracy .

For StableHLO information see StableHLO - cosine .

Cosh

See also XlaBuilder::Cosh .

Element-wise hyperbolic cosine x -> cosh(x) .

Cosh(operand)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operand | XlaOp | The operand to the function |

Cosh also supports the optional result_accuracy argument:

Cosh(operand, result_accuracy)

| Arguments | আদর্শ | Semantics |

|---|---|---|

operand | XlaOp | The operand to the function |

result_accuracy | optional ResultAccuracy | The types of accuracy the user can request for unary ops with multiple implementations |

For more information on result_accuracy see Result Accuracy .

CustomCall

See also XlaBuilder::CustomCall .

Call a user-provided function within a computation.

CustomCall documentation is provided in Developer details - XLA Custom Calls

For StableHLO information see StableHLO - custom_call .

Div

See also XlaBuilder::Div .

Performs element-wise division of dividend lhs and divisor rhs .

Div(lhs, rhs)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

Integer division overflow (signed/unsigned division/remainder by zero or signed division/remainder of INT_SMIN with -1 ) produces an implementation defined value.

The arguments' shapes have to be either similar or compatible. See the broadcasting documentation about what it means for shapes to be compatible. The result of an operation has a shape which is the result of broadcasting the two input arrays. In this variant, operations between arrays of different ranks are not supported, unless one of the operands is a scalar.

An alternative variant with different-dimensional broadcasting support exists for Div:

Div(lhs,rhs, broadcast_dimensions)

| Arguments | আদর্শ | Semantics |

|---|---|---|

| lhs | XlaOp | Left-hand-side operand: array of type T |

| rhs | XlaOp | Left-hand-side operand: array of type T |

| broadcast_dimension | ArraySlice | Which dimension in the target shape each dimension of the operand shape corresponds to |

This variant of the operation should be used for arithmetic operations between arrays of different ranks (such as adding a matrix to a vector).

The additional broadcast_dimensions operand is a slice of integers specifying the dimensions to use for broadcasting the operands. The semantics are described in detail on the broadcasting page .

For StableHLO information see StableHLO - divide .

ডোমেইন

See also HloInstruction::CreateDomain .

Domain may appear in HLO dumps, but it is not intended to be constructed manually by end users.

Dot

See also XlaBuilder::Dot .

Dot(lhs, rhs, precision_config, preferred_element_type)

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | array of type T |

rhs | XlaOp | array of type T |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

The exact semantics of this operation depend on the ranks of the operands:

| Input | Output | Semantics |

|---|---|---|

vector [n] dot vector [n] | scalar | vector dot product |

matrix [mxk] dot vector [k] | vector [m] | matrix-vector multiplication |

matrix [mxk] dot matrix [kxn] | matrix [mxn] | matrix-matrix multiplication |

The operation performs sum of products over the second dimension of lhs (or the first if it has 1 dimension) and the first dimension of rhs . These are the "contracted" dimensions. The contracted dimensions of lhs and rhs must be of the same size. In practice, it can be used to perform dot products between vectors, vector/matrix multiplications or matrix/matrix multiplications.

precision_config is used to indicate the precision configuration. The level dictates whether hardware should attempt to generate more machine code instructions to provide more accurate dtype emulation when needed (ie emulating f32 on a TPU that only supports bf16 matmuls). Values may be DEFAULT , HIGH , HIGHEST . Additional details in the MXU sections .

preferred_element_type is a scalar element of higher/lower precision output types used for accumulation. preferred_element_type recommends the accumulation type for the given operation, however it is not guaranteed. This allows for some hardware backends to instead accumulate in a different type and convert to the preferred output type.

For StableHLO information see StableHLO - dot .

DotGeneral

See also XlaBuilder::DotGeneral .

DotGeneral(lhs, rhs, dimension_numbers, precision_config, preferred_element_type)

| Arguments | আদর্শ | Semantics |

|---|---|---|

lhs | XlaOp | array of type T |

rhs | XlaOp | array of type T |

dimension_numbers | DotDimensionNumbers | contracting and batch dimension numbers |

precision_config | optional PrecisionConfig | enum for level of precision |

preferred_element_type | optional PrimitiveType | enum of scalar element type |

Similar to Dot, but allows contracting and batch dimension numbers to be specified for both the lhs and rhs .

| DotDimensionNumbers Fields | আদর্শ | Semantics |

|---|---|---|

lhs_contracting_dimensions | repeated int64 | lhs contracting dimension numbers |

rhs_contracting_dimensions | repeated int64 | rhs contracting dimension numbers |

lhs_batch_dimensions | repeated int64 | lhs batch dimension numbers |

rhs_batch_dimensions | repeated int64 | rhs batch dimension numbers |

DotGeneral performs the sum of products over contracting dimensions specified in dimension_numbers .

Associated contracting dimension numbers from the lhs and rhs do not need to be the same but must have the same dimension sizes.

Example with contracting dimension numbers:

lhs = { {1.0, 2.0, 3.0},

{4.0, 5.0, 6.0} }

rhs = { {1.0, 1.0, 1.0},

{2.0, 2.0, 2.0} }

DotDimensionNumbers dnums;

dnums.add_lhs_contracting_dimensions(1);

dnums.add_rhs_contracting_dimensions(1);

DotGeneral(lhs, rhs, dnums) -> { { 6.0, 12.0},

{15.0, 30.0} }