A seguir, descrevemos a semântica das operações definidas na interface

XlaBuilder. Normalmente, essas operações são mapeadas de um para um para as operações definidas na interface RPC em xla_data.proto.

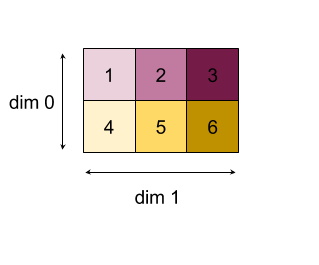

Uma observação sobre a nomenclatura: o tipo de dados generalizado com que a XLA trabalha é uma matriz N-dimensional que contém elementos de algum tipo uniforme (como ponto flutuante de 32 bits). Em toda a documentação, array é usado para denotar uma matriz de dimensão arbitrária. Para facilitar, os casos especiais têm nomes mais específicos e conhecidos. Por exemplo, um vetor é uma matriz unidimensional, e uma matriz é uma matriz bidimensional.

Saiba mais sobre a estrutura de uma operação em Formas e layout e Layout em blocos.

Abdômen

Consulte também

XlaBuilder::Abs.

Valor absoluto de elemento x -> |x|.

Abs(operand)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

Para informações sobre o StableHLO, consulte StableHLO: abs.

Adicionar

Consulte também

XlaBuilder::Add.

Executa a adição de elementos de lhs e rhs.

Add(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de diferentes dimensões para "Add":

Add(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Para informações sobre o StableHLO, consulte StableHLO: adicionar.

AddDependency

Consulte também

HloInstruction::AddDependency.

AddDependency pode aparecer em despejos de HLO, mas não foi criado para ser construído manualmente por usuários finais.

AfterAll

Consulte também

XlaBuilder::AfterAll.

"AfterAll" usa um número variádico de tokens e produz um único token. Os tokens

são tipos primitivos que podem ser encadeados entre operações com efeitos colaterais para

impor a ordenação. AfterAll pode ser usado como uma junção de tokens para ordenar uma

operação após um conjunto de operações.

AfterAll(tokens)

| Argumentos | Tipo | Semântica |

|---|---|---|

tokens |

vetor de XlaOp |

número variádico de tokens |

Para informações sobre o StableHLO, consulte StableHLO - after_all.

AllGather

Consulte também

XlaBuilder::AllGather.

Realiza a concatenação entre réplicas.

AllGather(operand, all_gather_dimension, shard_count, replica_groups,

channel_id, layout, use_global_device_ids)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand

|

XlaOp

|

Matriz para concatenar em todas as réplicas |

all_gather_dimension |

int64 |

Dimensão de concatenação |

shard_count

|

int64

|

O tamanho de cada grupo de réplicas |

replica_groups

|

vetor de vetores de

int64 |

Grupos entre os quais a concatenação é realizada |

channel_id

|

opcional

ChannelHandle |

ID do canal opcional para comunicação entre módulos |

layout

|

opcional Layout

|

Cria um padrão de layout que captura o layout correspondente no argumento. |

use_global_device_ids

|

opcional bool

|

Retorna verdadeiro se os IDs na configuração ReplicaGroup representarem um ID global. |

replica_groupsé uma lista de grupos de réplicas entre os quais a concatenação é realizada. O ID da réplica atual pode ser recuperado usandoReplicaId. A ordem das réplicas em cada grupo determina a ordem em que as entradas são localizadas no resultado.replica_groupsprecisa estar vazio (nesse caso, todas as réplicas pertencem a um único grupo, ordenado de0aN - 1) ou conter o mesmo número de elementos que o número de réplicas. Por exemplo,replica_groups = {0, 2}, {1, 3}realiza a concatenação entre as réplicas0e2, e1e3.shard_counté o tamanho de cada grupo de réplicas. Precisamos disso nos casos em quereplica_groupsestão vazios.channel_idé usado para comunicação entre módulos: apenas operaçõesall-gathercom o mesmochannel_idpodem se comunicar entre si.use_global_device_idsRetorna "true" se os IDs na configuração do ReplicaGroup representarem um ID global de (replica_id * partition_count + partition_id) em vez de um ID de réplica. Isso permite um agrupamento mais flexível de dispositivos se essa redução total for entre partições e entre réplicas.

O formato de saída é o formato de entrada com o all_gather_dimension shard_count vezes maior. Por exemplo, se houver duas réplicas e o operando tiver o valor [1.0, 2.5] e [3.0, 5.25], respectivamente, nas duas réplicas, o valor de saída dessa operação em que all_gather_dim é 0 será [1.0, 2.5, 3.0,5.25] nas duas réplicas.

A API de AllGather é decomposta internamente em duas instruções HLO (AllGatherStart e AllGatherDone).

Consulte também

HloInstruction::CreateAllGatherStart.

AllGatherStart e AllGatherDone servem como primitivos em HLO. Essas operações podem aparecer em despejos de HLO, mas não devem ser criadas manualmente por usuários finais.

Para informações sobre o StableHLO, consulte StableHLO: all_gather.

AllReduce

Consulte também

XlaBuilder::AllReduce.

Realiza uma computação personalizada em várias réplicas.

AllReduce(operand, computation, replica_groups, channel_id,

shape_with_layout, use_global_device_ids)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand

|

XlaOp

|

Matriz ou tupla não vazia de matrizes para reduzir em réplicas. |

computation |

XlaComputation |

Cálculo de redução |

replica_groups

|

ReplicaGroup vetor

|

Grupos entre os quais as reduções são realizadas |

channel_id

|

opcional

ChannelHandle |

ID do canal opcional para comunicação entre módulos |

shape_with_layout

|

opcional Shape

|

Define o layout dos dados transferidos. |

use_global_device_ids

|

opcional bool

|

Retorna verdadeiro se os IDs na configuração ReplicaGroup representarem um ID global. |

- Quando

operandé uma tupla de matrizes, a redução completa é realizada em cada elemento da tupla. replica_groupsé uma lista de grupos de réplicas entre os quais a redução é realizada. O ID da réplica atual pode ser recuperado usandoReplicaId.replica_groupsprecisa estar vazio (nesse caso, todas as réplicas pertencem a um único grupo) ou conter o mesmo número de elementos que o número de réplicas. Por exemplo,replica_groups = {0, 2}, {1, 3}realiza a redução entre as réplicas0e2, e1e3.channel_idé usado para comunicação entre módulos: apenas operaçõesall-reducecom o mesmochannel_idpodem se comunicar entre si.shape_with_layout: força o layout do AllReduce para o layout especificado. Isso é usado para garantir o mesmo layout para um grupo de operações AllReduce compiladas separadamente.use_global_device_idsRetorna "true" se os IDs na configuração do ReplicaGroup representarem um ID global de (replica_id * partition_count + partition_id) em vez de um ID de réplica. Isso permite um agrupamento mais flexível de dispositivos se essa redução total for entre partições e entre réplicas.

O formato da saída é igual ao da entrada. Por exemplo, se houver duas réplicas e o operando tiver o valor [1.0, 2.5] e [3.0, 5.25], respectivamente, nas duas réplicas, o valor de saída dessa operação e o cálculo de soma serão [4.0, 7.75] nas duas réplicas. Se a entrada for uma tupla, a saída também será uma tupla.

Para calcular o resultado de AllReduce, é necessário ter uma entrada de cada réplica. Portanto, se uma réplica executar um nó AllReduce mais vezes do que outra, a primeira vai esperar para sempre. Como todas as réplicas executam o mesmo programa, não há muitas maneiras de isso acontecer. No entanto, é possível quando a condição de um loop "while" depende de dados de infeed e os dados que são infeed fazem com que o loop "while" itere mais vezes em uma réplica do que em outra.

A API de AllReduce é decomposta internamente em duas instruções HLO (AllReduceStart e AllReduceDone).

Consulte também

HloInstruction::CreateAllReduceStart.

AllReduceStart e AllReduceDone servem como primitivos em HLO. Essas operações podem aparecer em despejos de HLO, mas não devem ser criadas manualmente por usuários finais.

CrossReplicaSum

Consulte também

XlaBuilder::CrossReplicaSum.

Realiza AllReduce com um cálculo de soma.

CrossReplicaSum(operand, replica_groups)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand

|

XlaOp | Matriz ou tupla não vazia de matrizes para reduzir em todas as réplicas. |

replica_groups

|

vetor de vetores de

int64 |

Grupos entre os quais as reduções são realizadas |

Retorna a soma do valor do operando em cada subgrupo de réplicas. Todas as réplicas fornecem uma entrada para a soma e recebem o resultado para cada subgrupo.

AllToAll

Consulte também

XlaBuilder::AllToAll.

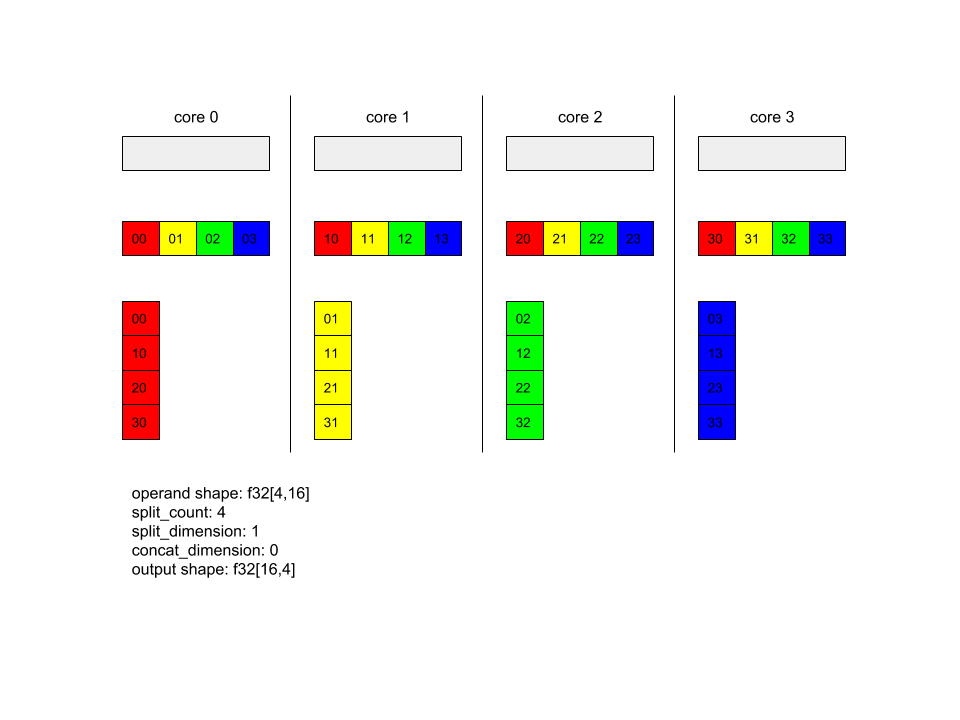

AllToAll é uma operação coletiva que envia dados de todos os núcleos para todos os núcleos. Ele tem duas fases:

- A fase de dispersão. Em cada núcleo, o operando é dividido em

split_countblocos ao longo dasplit_dimensions, e os blocos são distribuídos para todos os núcleos. Por exemplo, o iésimo bloco é enviado para o iésimo núcleo. - A fase de coleta. Cada núcleo concatena os blocos recebidos ao longo da

concat_dimension.

Os núcleos participantes podem ser configurados por:

replica_groups: cada ReplicaGroup contém uma lista de IDs de réplicas que participam da computação. O ID da réplica atual pode ser recuperado usandoReplicaId. O AllToAll será aplicado em subgrupos na ordem especificada. Por exemplo,replica_groups = { {1,2,3}, {4,5,0} }significa que um AllToAll será aplicado em réplicas{1, 2, 3}, na fase de coleta, e os blocos recebidos serão concatenados na mesma ordem de 1, 2, 3. Em seguida, outro AllToAll será aplicado nas réplicas 4, 5 e 0, e a ordem de concatenação também será 4, 5 e 0. Sereplica_groupsestiver vazio, todas as réplicas vão pertencer a um grupo, na ordem de concatenação da aparência delas.

Pré-requisitos:

- O tamanho da dimensão do operando em

split_dimensioné divisível porsplit_count. - O formato do operando não é uma tupla.

AllToAll(operand, split_dimension, concat_dimension, split_count,

replica_groups, layout, channel_id)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

matriz de entrada n-dimensional |

split_dimension

|

int64

|

Um valor no intervalo [0,n) que nomeia a dimensão ao longo da qual o operando é dividido. |

concat_dimension

|

int64

|

Um valor no intervalo [0,n) que nomeia a dimensão ao longo da qual os blocos de divisão são concatenados. |

split_count

|

int64

|

O número de núcleos que participam desta operação. Se replica_groups estiver vazio, esse valor será o número de réplicas. Caso contrário, ele será igual ao número de réplicas em cada grupo. |

replica_groups

|

ReplicaGroupvetor

|

Cada grupo contém uma lista de IDs de réplica. |

layout |

opcional Layout |

layout de memória especificado pelo usuário |

channel_id

|

opcional ChannelHandle

|

identificador exclusivo para cada par send/recv |

Consulte xla::shapes para mais informações sobre formas e layouts.

Para informações sobre o StableHLO, consulte StableHLO: all_to_all.

AllToAll: exemplo 1.

XlaBuilder b("alltoall");

auto x = Parameter(&b, 0, ShapeUtil::MakeShape(F32, {4, 16}), "x");

AllToAll(

x,

/*split_dimension=*/ 1,

/*concat_dimension=*/ 0,

/*split_count=*/ 4);

No exemplo acima, há quatro núcleos participando do Alltoall. Em cada núcleo, o operando é dividido em quatro partes ao longo da dimensão 1, de modo que cada parte tem formato f32[4,4]. As quatro partes são distribuídas para todos os núcleos. Em seguida, cada núcleo concatena as partes recebidas ao longo da dimensão 0, na ordem dos núcleos 0 a 4. Portanto, a saída em cada núcleo tem o formato f32[16,4].

AllToAll - Exemplo 2 - StableHLO

No exemplo acima, há duas réplicas participando do AllToAll. Em cada réplica, o operando tem a forma f32[2,4]. O operando é dividido em duas partes ao longo da dimensão 1, então cada parte tem a forma f32[2,2]. As duas partes são trocadas entre as réplicas de acordo com a posição delas no grupo. Cada réplica coleta a parte correspondente dos dois operandos e os concatena ao longo da dimensão 0. Como resultado, a saída em cada réplica tem o formato f32[4,2].

RaggedAllToAll

Consulte também

XlaBuilder::RaggedAllToAll.

O RaggedAllToAll realiza uma operação coletiva de todos para todos, em que a entrada e a saída são tensores irregulares.

RaggedAllToAll(input, input_offsets, send_sizes, output, output_offsets,

recv_sizes, replica_groups, channel_id)

| Argumentos | Tipo | Semântica |

|---|---|---|

input |

XlaOp |

Matriz N do tipo T |

input_offsets |

XlaOp |

Matriz N do tipo T |

send_sizes |

XlaOp |

Matriz N do tipo T |

output |

XlaOp |

Matriz N do tipo T |

output_offsets |

XlaOp |

Matriz N do tipo T |

recv_sizes |

XlaOp |

Matriz N do tipo T |

replica_groups

|

ReplicaGroup vetor

|

Cada grupo contém uma lista de IDs de réplica. |

channel_id

|

opcional ChannelHandle

|

identificador exclusivo para cada par send/recv |

Tensores irregulares são definidos por um conjunto de três tensores:

data: o tensordataé irregular ao longo da dimensão mais externa, em que cada elemento indexado tem tamanho variável.offsets: o tensoroffsetsindexa a dimensão mais externa do tensordatae representa o deslocamento inicial de cada elemento irregular do tensordata.sizes: o tensorsizesrepresenta o tamanho de cada elemento irregular do tensordata, em que o tamanho é especificado em unidades de subelementos. Um subelemento é definido como o sufixo da forma do tensor "data" obtido removendo a dimensão mais externa.- Os tensores

offsetsesizesprecisam ter o mesmo tamanho.

Exemplo de um tensor irregular:

data: [8,3] =

{ {a,b,c},{d,e,f},{g,h,i},{j,k,l},{m,n,o},{p,q,r},{s,t,u},{v,w,x} }

offsets: [3] = {0, 1, 4}

sizes: [3] = {1, 3, 4}

// Index 'data' at 'offsets'[0], 'sizes'[0]' // {a,b,c}

// Index 'data' at 'offsets'[1], 'sizes'[1]' // {d,e,f},{g,h,i},{j,k,l}

// Index 'data' at 'offsets'[2], 'sizes'[2]' // {m,n,o},{p,q,r},{s,t,u},{v,w,x}

output_offsets precisa ser fragmentado de forma que cada réplica tenha offsets na perspectiva de saída da réplica de destino.

Para o i-ésimo deslocamento de saída, a réplica atual vai enviar

a atualização input[input_offsets[i]:input_offsets[i]+input_sizes[i]] para a i-ésima

réplica, que será gravada em

output_i[output_offsets[i]:output_offsets[i]+send_sizes[i]] na i-ésima réplica

output.

Por exemplo, se tivermos duas réplicas:

replica 0:

input: [1, 2, 2]

output:[0, 0, 0, 0]

input_offsets: [0, 1]

send_sizes: [1, 2]

output_offsets: [0, 0]

recv_sizes: [1, 1]

replica 1:

input: [3, 4, 0]

output: [0, 0, 0, 0]

input_offsets: [0, 1]

send_sizes: [1, 1]

output_offsets: [1, 2]

recv_sizes: [2, 1]

// replica 0's result will be: [1, 3, 0, 0]

// replica 1's result will be: [2, 2, 4, 0]

O HLO irregular de todos para todos tem os seguintes argumentos:

input: tensor de dados de entrada irregulares.output: tensor de dados de saída irregulares.input_offsets: tensor de deslocamentos de entrada irregulares.send_sizes: tensor irregular de tamanhos de envio.output_offsets: matriz de intervalos irregulares na saída da réplica de destino.recv_sizes: tensor de tamanhos de recebimento irregulares.

Os tensores *_offsets e *_sizes precisam ter o mesmo formato.

Há duas formas compatíveis para os tensores *_offsets e *_sizes:

[num_devices]em que ragged-all-to-all pode enviar no máximo uma atualização para cada dispositivo remoto no grupo de réplicas. Exemplo:

for (remote_device_id : replica_group) {

SEND input[input_offsets[remote_device_id]],

output[output_offsets[remote_device_id]],

send_sizes[remote_device_id] }

[num_devices, num_updates]em que ragged-all-to-all pode enviar aténum_updatesatualizações para o mesmo dispositivo remoto (cada uma em diferentes offsets), para cada dispositivo remoto no grupo de réplicas.

Exemplo:

for (remote_device_id : replica_group) {

for (update_idx : num_updates) {

SEND input[input_offsets[remote_device_id][update_idx]],

output[output_offsets[remote_device_id][update_idx]]],

send_sizes[remote_device_id][update_idx] } }

E

Consulte também

XlaBuilder::And.

Executa um AND bit a bit de dois tensores lhs e rhs.

And(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para "And":

And(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Para informações sobre o StableHLO, consulte StableHLO - and.

Assíncrona

Consulte também HloInstruction::CreateAsyncStart,

HloInstruction::CreateAsyncUpdate,

HloInstruction::CreateAsyncDone.

AsyncDone, AsyncStart e AsyncUpdate são instruções HLO internas usadas para operações assíncronas e servem como primitivos em HLO. Essas operações podem aparecer

em despejos de HLO, mas não devem ser construídas manualmente por usuários finais.

Atan2

Consulte também

XlaBuilder::Atan2.

Executa a operação atan2 elemento a elemento em lhs e rhs.

Atan2(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para Atan2:

Atan2(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Para informações sobre o StableHLO, consulte StableHLO: atan2.

BatchNormGrad

Consulte também

XlaBuilder::BatchNormGrad

e o artigo original sobre normalização em lote

para uma descrição detalhada do algoritmo.

Calcula gradientes de normalização em lote.

BatchNormGrad(operand, scale, batch_mean, batch_var, grad_output, epsilon,

feature_index)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp | Matriz n-dimensional a ser normalizada (x) |

scale |

XlaOp | Matriz unidimensional (\(\gamma\)) |

batch_mean |

XlaOp | Matriz unidimensional (\(\mu\)) |

batch_var |

XlaOp | Matriz unidimensional (\(\sigma^2\)) |

grad_output |

XlaOp | Gradientes transmitidos para BatchNormTraining (\(\nabla y\)) |

epsilon |

float |

Valor de épsilon (\(\epsilon\)) |

feature_index |

int64 |

Indexação para dimensionar o recurso em operand |

Para cada recurso na dimensão de recurso (feature_index é o índice da dimensão de recurso em operand), a operação calcula os gradientes em relação a operand, offset e scale em todas as outras dimensões. O feature_index precisa ser um índice válido para a dimensão de recurso em operand.

Os três gradientes são definidos pelas seguintes fórmulas (supondo uma matriz de quatro dimensões como operand e com índice de dimensão de recurso l, tamanho do lote m e tamanhos espaciais w e h):

\[ \begin{split} c_l&= \frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \left( \nabla y_{ijkl} \frac{x_{ijkl} - \mu_l}{\sigma^2_l+\epsilon} \right) \\\\ d_l&= \frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \nabla y_{ijkl} \\\\ \nabla x_{ijkl} &= \frac{\gamma_{l} }{\sqrt{\sigma^2_{l}+\epsilon} } \left( \nabla y_{ijkl} - d_l - c_l (x_{ijkl} - \mu_{l}) \right) \\\\ \nabla \gamma_l &= \sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \left( \nabla y_{ijkl} \frac{x_{ijkl} - \mu_l}{\sqrt{\sigma^2_{l}+\epsilon} } \right) \\\\\ \nabla \beta_l &= \sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h \nabla y_{ijkl} \end{split} \]

As entradas batch_mean e batch_var representam valores de momentos em dimensões espaciais e de lote.

O tipo de saída é uma tupla de três identificadores:

| Saídas | Tipo | Semântica |

|---|---|---|

grad_operand

|

XlaOp | gradiente em relação à entrada operand (\(\nabla x\)) |

grad_scale

|

XlaOp | gradiente em relação à entrada **scale ** (\(\nabla\gamma\)) |

grad_offset

|

XlaOp | gradiente em relação à entrada offset(\(\nabla\beta\)) |

Para informações sobre o StableHLO, consulte StableHLO - batch_norm_grad.

BatchNormInference

Consulte também

XlaBuilder::BatchNormInference

e o artigo original sobre normalização em lote

para uma descrição detalhada do algoritmo.

Normaliza uma matriz em lote e dimensões espaciais.

BatchNormInference(operand, scale, offset, mean, variance, epsilon,

feature_index)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp | Matriz n-dimensional a ser normalizada |

scale |

XlaOp | Matriz unidimensional |

offset |

XlaOp | Matriz unidimensional |

mean |

XlaOp | Matriz unidimensional |

variance |

XlaOp | Matriz unidimensional |

epsilon |

float |

Valor de épsilon |

feature_index |

int64 |

Indexação para dimensionar o recurso em operand |

Para cada recurso na dimensão de recurso (feature_index é o índice da dimensão de recurso em operand), a operação calcula a média e a variância em todas as outras dimensões e usa esses valores para normalizar cada elemento em operand. O feature_index precisa ser um índice válido para a dimensão de recurso em operand.

BatchNormInference é equivalente a chamar BatchNormTraining sem calcular mean e variance para cada lote. Em vez disso, ele usa as entradas mean e variance como valores estimados. O objetivo dessa operação é reduzir a latência na inferência, daí o nome BatchNormInference.

A saída é uma matriz normalizada n-dimensional com o mesmo formato da entrada operand.

Para informações sobre o StableHLO, consulte StableHLO - batch_norm_inference.

BatchNormTraining

Consulte também XlaBuilder::BatchNormTraining e the original batch normalization paper para uma descrição detalhada do algoritmo.

Normaliza uma matriz em lote e dimensões espaciais.

BatchNormTraining(operand, scale, offset, epsilon, feature_index)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

Matriz n-dimensional a ser normalizada (x) |

scale |

XlaOp |

Matriz unidimensional (\(\gamma\)) |

offset |

XlaOp |

Matriz unidimensional (\(\beta\)) |

epsilon |

float |

Valor de épsilon (\(\epsilon\)) |

feature_index |

int64 |

Indexação para dimensionar o recurso em operand |

Para cada recurso na dimensão de recurso (feature_index é o índice da dimensão de recurso em operand), a operação calcula a média e a variância em todas as outras dimensões e usa esses valores para normalizar cada elemento em operand. O feature_index precisa ser um índice válido para a dimensão de recurso em operand.

O algoritmo funciona da seguinte maneira para cada lote em operand \(x\) que contém melementos com w e h como o tamanho das dimensões espaciais (supondo que operandseja uma matriz de quatro dimensões):

Calcula a média do lote \(\mu_l\) para cada recurso

lna dimensão do recurso: \(\mu_l=\frac{1}{mwh}\sum_{i=1}^m\sum_{j=1}^w\sum_{k=1}^h x_{ijkl}\)Calcula a variância do lote \(\sigma^2_l\): $\sigma^2l=\frac{1}{mwh}\sum{i=1}^m\sum{j=1}^w\sum{k=1}^h (x_{ijkl} - \mu_l)^2$

Normaliza, dimensiona e muda: \(y_{ijkl}=\frac{\gamma_l(x_{ijkl}-\mu_l)}{\sqrt[2]{\sigma^2_l+\epsilon} }+\beta_l\)

O valor de epsilon, geralmente um número pequeno, é adicionado para evitar erros de divisão por zero.

O tipo de saída é uma tupla de três XlaOps:

| Saídas | Tipo | Semântica |

|---|---|---|

output

|

XlaOp

|

Matriz n-dimensional com a mesma forma da entrada operand (y) |

batch_mean |

XlaOp |

Matriz unidimensional (\(\mu\)) |

batch_var |

XlaOp |

Matriz unidimensional (\(\sigma^2\)) |

Os batch_mean e batch_var são momentos calculados em todas as dimensões espaciais e de lote usando as fórmulas acima.

Para informações sobre o StableHLO, consulte StableHLO - batch_norm_training.

Bitcast

Consulte também

HloInstruction::CreateBitcast.

Bitcast pode aparecer em despejos de HLO, mas não foi criado para ser construído

manualmente por usuários finais.

BitcastConvertType

Consulte também

XlaBuilder::BitcastConvertType.

Semelhante a um tf.bitcast no TensorFlow, realiza uma operação de bitcast de elemento a elemento de uma forma de dados para uma forma de destino. O tamanho da entrada e da saída precisa ser igual. Por exemplo, elementos s32 se tornam elementos f32 usando a rotina bitcast, e um elemento s32 se torna quatro elementos s8. O Bitcast é implementado como uma transmissão de baixo nível. Portanto, máquinas com representações de ponto flutuante diferentes vão gerar resultados diferentes.

BitcastConvertType(operand, new_element_type)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

matriz do tipo T com dimensões D |

new_element_type |

PrimitiveType |

tipo U |

As dimensões do operando e da forma de destino precisam corresponder, exceto a última dimensão, que vai mudar pela proporção do tamanho primitivo antes e depois da conversão.

Os tipos de elementos de origem e destino não podem ser tuplas.

Para mais informações sobre o StableHLO, consulte StableHLO - bitcast_convert.

Conversão de bitcast para tipo primitivo de largura diferente

A instrução BitcastConvert HLO é compatível com o caso em que o tamanho do tipo de elemento de saída T' não é igual ao tamanho do elemento de entrada T. Como toda a operação é conceitualmente um bitcast e não muda os bytes subjacentes, a forma do elemento de saída precisa mudar. Para B = sizeof(T), B' =

sizeof(T'), há dois casos possíveis.

Primeiro, quando B > B', o formato da saída recebe uma nova dimensão secundária de tamanho B/B'. Exemplo:

f16[10,2]{1,0} %output = f16[10,2]{1,0} bitcast-convert(f32[10]{0} %input)

A regra permanece a mesma para escalares efetivos:

f16[2]{0} %output = f16[2]{0} bitcast-convert(f32[] %input)

Como alternativa, para B' > B, a instrução exige que a última dimensão lógica da forma de entrada seja igual a B'/B, e essa dimensão é descartada durante a conversão:

f32[10]{0} %output = f32[10]{0} bitcast-convert(f16[10,2]{1,0} %input)

As conversões entre diferentes larguras de bits não são feitas elemento a elemento.

Transmitir

Consulte também

XlaBuilder::Broadcast.

Adiciona dimensões a uma matriz duplicando os dados nela.

Broadcast(operand, broadcast_sizes)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

A matriz a ser duplicada. |

broadcast_sizes |

ArraySlice<int64> |

Os tamanhos das novas dimensões |

As novas dimensões são inseridas à esquerda. Por exemplo, se broadcast_sizes tiver valores {a0, ..., aN} e a forma do operando tiver dimensões {b0, ..., bM}, a forma da saída terá dimensões {a0, ..., aN, b0, ..., bM}.

O novo índice de dimensões em cópias do operando, ou seja,

output[i0, ..., iN, j0, ..., jM] = operand[j0, ..., jM]

Por exemplo, se operand for um escalar f32 com valor 2.0f, e broadcast_sizes for {2, 3}, o resultado será uma matriz com formato f32[2, 3] e todos os valores no resultado serão 2.0f.

Para informações sobre o StableHLO, consulte StableHLO: transmissão.

BroadcastInDim

Consulte também

XlaBuilder::BroadcastInDim.

Aumenta o tamanho e o número de dimensões de uma matriz duplicando os dados nela.

BroadcastInDim(operand, out_dim_size, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

A matriz a ser duplicada. |

out_dim_size

|

ArraySlice<int64>

|

Os tamanhos das dimensões da forma de destino |

broadcast_dimensions

|

ArraySlice<int64>

|

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Semelhante à transmissão, mas permite adicionar dimensões em qualquer lugar e expandir as dimensões atuais com tamanho 1.

O operand é transmitido para a forma descrita por out_dim_size.

broadcast_dimensions mapeia as dimensões de operand para as dimensões da forma de destino. Ou seja, a i-ésima dimensão do operando é mapeada para a dimensão broadcast_dimension[i] da forma de saída. As dimensões de operand precisam ter tamanho 1 ou o mesmo tamanho da dimensão na forma de saída a que são mapeadas. As dimensões restantes são preenchidas com dimensões de tamanho 1. A transmissão de dimensões degeneradas é feita ao longo dessas dimensões para alcançar a forma de saída. A semântica é descrita em detalhes na

página de transmissão.

Ligar

Consulte também

XlaBuilder::Call.

Invoca um cálculo com os argumentos fornecidos.

Call(computation, operands...)

| Argumentos | Tipo | Semântica |

|---|---|---|

computation

|

XlaComputation

|

cálculo do tipo T_0, T_1, ...,

T_{N-1} -> S com N parâmetros de tipo arbitrário |

operands |

sequência de N XlaOps |

N argumentos de tipo arbitrário |

A aridade e os tipos de operands precisam corresponder aos parâmetros de computation. É permitido não ter operands.

CompositeCall

Consulte também

XlaBuilder::CompositeCall.

Encapsula uma operação composta por outras operações do StableHLO, recebendo entradas e composite_attributes e produzindo resultados. A semântica da operação é implementada pelo atributo de decomposição. A operação composta pode ser substituída pela decomposição sem mudar a semântica do programa. Nos casos em que a incorporação da decomposição não fornece a mesma semântica de operação, prefira usar custom_call.

O campo de versão (padrão é 0) é usado para indicar quando a semântica de um composto muda.

Essa operação é implementada como um kCall com o atributo is_composite=true. O campo

decomposition é especificado pelo atributo computation. Os atributos do front-end armazenam os atributos restantes prefixados com composite..

Exemplo de operação CompositeCall:

f32[] call(f32[] %cst), to_apply=%computation, is_composite=true,

frontend_attributes = {

composite.name="foo.bar",

composite.attributes={n = 1 : i32, tensor = dense<1> : tensor<i32>},

composite.version="1"

}

CompositeCall(computation, operands..., name, attributes, version)

| Argumentos | Tipo | Semântica |

|---|---|---|

computation

|

XlaComputation

|

cálculo do tipo T_0, T_1, ...,

T_{N-1} -> S com N parâmetros de tipo arbitrário |

operands |

sequência de N XlaOps |

número variádico de valores |

name |

string |

nome do composto |

attributes

|

opcional string

|

dicionário opcional de atributos em formato de string |

version

|

opcional int64

|

número para atualizações de versão para semântica da operação composta |

O decomposition de uma operação não é um campo chamado, mas aparece como um atributo to_apply

que aponta para a função que contém a implementação

de nível inferior, ou seja, to_apply=%funcname.

Para mais informações sobre composição e decomposição, consulte a especificação do StableHLO.

Cbrt

Consulte também

XlaBuilder::Cbrt.

Operação de raiz cúbica com elementos x -> cbrt(x).

Cbrt(operand)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

O Cbrt também é compatível com o argumento opcional result_accuracy:

Cbrt(operand, result_accuracy)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

result_accuracy

|

opcional ResultAccuracy

|

Os tipos de precisão que o usuário pode solicitar para operações unárias com várias implementações |

Para mais informações sobre result_accuracy, consulte

Precisão dos resultados.

Para informações sobre o StableHLO, consulte StableHLO: cbrt.

Arredondar para cima

Consulte também

XlaBuilder::Ceil.

Teto de elemento a elemento x -> ⌈x⌉.

Ceil(operand)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

Para informações sobre o StableHLO, consulte StableHLO: ceil.

Cholesky

Consulte também

XlaBuilder::Cholesky.

Calcula a decomposição de Cholesky de um lote de matrizes simétricas (hermitianas) positivas definidas.

Cholesky(a, lower)

| Argumentos | Tipo | Semântica |

|---|---|---|

a

|

XlaOp

|

uma matriz de um tipo complexo ou de ponto flutuante com mais de duas dimensões. |

lower |

bool |

se o triângulo superior ou inferior de a será usado. |

Se lower for true, vai calcular matrizes triangulares inferiores l de forma que $a = l .

l^T$. Se lower for false, vai calcular matrizes triangulares superiores u de forma que\(a = u^T . u\).

Os dados de entrada são lidos apenas do triângulo inferior/superior de a, dependendo do valor de lower. Os valores do outro triângulo são ignorados. Os dados de saída são retornados no mesmo triângulo. Os valores no outro triângulo são definidos pela implementação e podem ser qualquer coisa.

Se a tiver mais de duas dimensões, ele será tratado como um lote de matrizes, em que todas, exceto as duas dimensões secundárias, são dimensões de lote.a

Se a não for simétrica (hermitiana) positiva definida, o resultado será definido pela implementação.

Para informações sobre o StableHLO, consulte StableHLO: cholesky.

Limitar

Consulte também

XlaBuilder::Clamp.

Restringe um operando ao intervalo entre um valor mínimo e máximo.

Clamp(min, operand, max)

| Argumentos | Tipo | Semântica |

|---|---|---|

min |

XlaOp |

matriz do tipo T |

operand |

XlaOp |

matriz do tipo T |

max |

XlaOp |

matriz do tipo T |

Dado um operando e valores mínimo e máximo, retorna o operando se ele estiver no intervalo entre o mínimo e o máximo. Caso contrário, retorna o valor mínimo se o operando estiver abaixo desse intervalo ou o valor máximo se o operando estiver acima desse intervalo. Ou seja, clamp(a, x, b) = min(max(a, x), b).

Todos os três precisam ter o mesmo formato. Como alternativa, como uma forma restrita de transmissão, min e/ou max podem ser um escalar do tipo T.

Exemplo com min e max escalares:

let operand: s32[3] = {-1, 5, 9};

let min: s32 = 0;

let max: s32 = 6;

==>

Clamp(min, operand, max) = s32[3]{0, 5, 6};

Para informações sobre o StableHLO, consulte StableHLO: clamp.

Recolher

Consulte também

XlaBuilder::Collapse.

e a operação tf.reshape.

Reduz as dimensões de uma matriz em uma dimensão.

Collapse(operand, dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

matriz do tipo T |

dimensions |

int64 vetor |

em ordem, subconjunto consecutivo das dimensões de T. |

A redução substitui o subconjunto especificado das dimensões do operando por uma única dimensão. Os argumentos de entrada são uma matriz arbitrária do tipo T e um vetor constante de tempo de compilação de índices de dimensão. Os índices de dimensão precisam ser um subconjunto ordenado (números de dimensão de baixo para cima) e consecutivo das dimensões de T. Portanto, {0, 1, 2}, {0, 1} ou {1, 2} são conjuntos de dimensões válidos, mas {1, 0} ou {0, 2} não são. Elas são substituídas por uma única dimensão nova, na mesma posição na sequência de dimensões que as substituídas, com o tamanho da nova dimensão igual ao produto dos tamanhos das dimensões originais. O menor número de dimensão em dimensions é a dimensão de variação mais lenta (mais importante) no aninhamento de loop que recolhe essas dimensões, e o maior número de dimensão é a variação mais rápida (mais secundária). Consulte o operador tf.reshape se for necessário um ordenamento de redução mais geral.

Por exemplo, seja v uma matriz de 24 elementos:

let v = f32[4x2x3] { { {10, 11, 12}, {15, 16, 17} },

{ {20, 21, 22}, {25, 26, 27} },

{ {30, 31, 32}, {35, 36, 37} },

{ {40, 41, 42}, {45, 46, 47} } };

// Collapse to a single dimension, leaving one dimension.

let v012 = Collapse(v, {0,1,2});

then v012 == f32[24] {10, 11, 12, 15, 16, 17,

20, 21, 22, 25, 26, 27,

30, 31, 32, 35, 36, 37,

40, 41, 42, 45, 46, 47};

// Collapse the two lower dimensions, leaving two dimensions.

let v01 = Collapse(v, {0,1});

then v01 == f32[4x6] { {10, 11, 12, 15, 16, 17},

{20, 21, 22, 25, 26, 27},

{30, 31, 32, 35, 36, 37},

{40, 41, 42, 45, 46, 47} };

// Collapse the two higher dimensions, leaving two dimensions.

let v12 = Collapse(v, {1,2});

then v12 == f32[8x3] { {10, 11, 12},

{15, 16, 17},

{20, 21, 22},

{25, 26, 27},

{30, 31, 32},

{35, 36, 37},

{40, 41, 42},

{45, 46, 47} };

Clz

Consulte também

XlaBuilder::Clz.

Contagem de zeros à esquerda por elemento.

Clz(operand)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

CollectiveBroadcast

Consulte também

XlaBuilder::CollectiveBroadcast.

Transmite dados entre réplicas. Os dados são enviados do primeiro ID de réplica em cada grupo para os outros IDs no mesmo grupo. Se um ID de réplica não estiver em nenhum grupo de réplicas, a saída nessa réplica será um tensor composto por 0s em shape.

CollectiveBroadcast(operand, replica_groups, channel_id)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

O operando da função |

replica_groups

|

ReplicaGroupvetor

|

Cada grupo contém uma lista de IDs de réplica |

channel_id

|

opcional ChannelHandle

|

identificador exclusivo para cada par send/recv |

Para informações sobre o StableHLO, consulte StableHLO: collective_broadcast.

CollectivePermute

Consulte também

XlaBuilder::CollectivePermute.

CollectivePermute é uma operação coletiva que envia e recebe dados entre réplicas.

CollectivePermute(operand, source_target_pairs, channel_id, inplace)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

matriz de entrada n-dimensional |

source_target_pairs

|

<int64, int64> vetor

|

Uma lista de pares (source_replica_id, target_replica_id). Para cada par, o operando é enviado da réplica de origem para a réplica de destino. |

channel_id

|

opcional ChannelHandle

|

ID do canal opcional para comunicação entre módulos |

inplace

|

opcional bool

|

indica se a permutação deve ser feita no lugar |

Há as seguintes restrições no source_target_pairs:

- Dois pares não podem ter o mesmo ID de réplica de destino nem de origem.

- Se um ID de réplica não for um destino em nenhum par, a saída nessa réplica será um tensor composto de 0s com o mesmo formato da entrada.

A API da operação CollectivePermute é decomposta internamente em duas instruções HLO (CollectivePermuteStart e CollectivePermuteDone).

Consulte também

HloInstruction::CreateCollectivePermuteStart.

CollectivePermuteStart e CollectivePermuteDone servem como primitivos em HLO.

Essas operações podem aparecer em despejos de HLO, mas não devem ser construídas manualmente por usuários finais.

Para informações sobre o StableHLO, consulte StableHLO - collective_permute.

Comparar

Consulte também

XlaBuilder::Compare.

Executa uma comparação elemento a elemento de lhs e rhs do seguinte:

Eq

Consulte também

XlaBuilder::Eq.

Realiza uma comparação igual a por elemento de lhs e rhs.

\(lhs = rhs\)

Eq(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para a equação:

Eq(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Existe suporte para uma ordem total sobre os números de ponto flutuante para Eq, aplicando:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

EqTotalOrder(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Ne

Consulte também

XlaBuilder::Ne.

Executa uma comparação diferente de de elemento a elemento entre lhs e rhs.

\(lhs != rhs\)

Ne(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para Ne:

Ne(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Existe suporte para uma ordem total sobre os números de ponto flutuante para Ne, aplicando:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

NeTotalOrder(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Ge

Consulte também

XlaBuilder::Ge.

Executa uma comparação greater-or-equal-than elemento a elemento de lhs e rhs.

\(lhs >= rhs\)

Ge(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para Ge:

Ge(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Existe uma ordem total sobre os números de ponto flutuante para Gt, aplicando:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

GtTotalOrder(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Gt

Consulte também

XlaBuilder::Gt.

Executa uma comparação maior que de elemento a elemento de lhs e rhs.

\(lhs > rhs\)

Gt(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de diferentes dimensões para Gt:

Gt(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Le

Consulte também

XlaBuilder::Le.

Executa uma comparação less-or-equal-than de elemento a elemento de lhs e rhs.

\(lhs <= rhs\)

Le(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para Le:

Le(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Existe uma ordem total sobre os números de ponto flutuante para Le, aplicando:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

LeTotalOrder(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Lt

Consulte também

XlaBuilder::Lt.

Executa uma comparação menor que elemento a elemento de lhs e rhs.

\(lhs < rhs\)

Lt(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para Lt:

Lt(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Suporte a um pedido total sobre os números de ponto flutuante para Lt, aplicando:

\[-NaN < -Inf < -Finite < -0 < +0 < +Finite < +Inf < +NaN.\]

LtTotalOrder(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Para informações sobre o StableHLO, consulte StableHLO: comparação.

Complexo

Consulte também

XlaBuilder::Complex.

Realiza a conversão de elemento por elemento para um valor complexo de um par de valores reais e imaginários, lhs e rhs.

Complex(lhs, rhs)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

As formas dos argumentos precisam ser semelhantes ou compatíveis. Consulte a documentação de transmissão para saber o que significa a compatibilidade de formas. O resultado de uma operação tem uma forma que é o resultado da transmissão das duas matrizes de entrada. Nessa variante, as operações entre matrizes de ranks diferentes não são aceitas, a menos que um dos operandos seja um escalar.

Existe uma variante alternativa com suporte de transmissão de dimensões diferentes para números complexos:

Complex(lhs,rhs, broadcast_dimensions)

| Argumentos | Tipo | Semântica |

|---|---|---|

| lhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| rhs | XlaOp | Operando do lado esquerdo: matriz do tipo T |

| broadcast_dimension | ArraySlice |

A qual dimensão na forma de destino cada dimensão da forma de operando corresponde |

Essa variante da operação deve ser usada para operações aritméticas entre matrizes de ranks diferentes (como adicionar uma matriz a um vetor).

O operando broadcast_dimensions adicional é uma fração de números inteiros que especifica as dimensões a serem usadas para transmissão dos operandos. A semântica é descrita em detalhes na página de transmissão.

Para informações sobre o StableHLO, consulte StableHLO: complex.

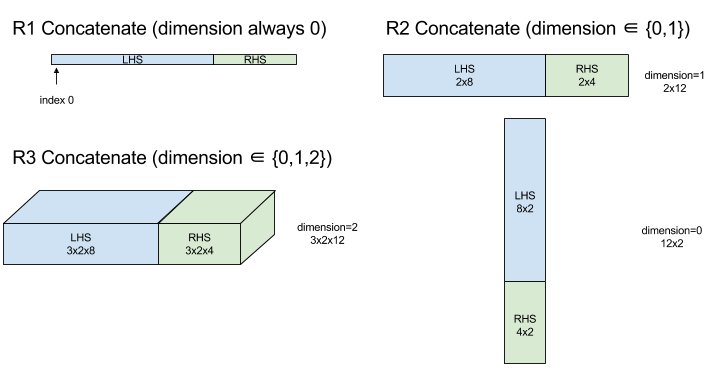

ConcatInDim (concatenação)

Consulte também

XlaBuilder::ConcatInDim.

A função CONCATENAR cria uma matriz com vários operandos de matriz. A matriz tem o mesmo número de dimensões que cada um dos operandos de matriz de entrada (que precisam ter o mesmo número de dimensões entre si) e contém os argumentos na ordem em que foram especificados.

Concatenate(operands..., dimension)

| Argumentos | Tipo | Semântica |

|---|---|---|

operands

|

sequência de N XlaOp

|

N matrizes do tipo T com dimensões [L0, L1, ...]. Exige N >= 1. |

dimension

|

int64

|

Um valor no intervalo [0, N) que nomeia a dimensão a ser concatenada entre os operands. |

Com exceção de dimension, todas as dimensões precisam ser iguais. Isso acontece porque o XLA não é compatível com matrizes irregulares. Além disso, valores de dimensão zero não podem ser concatenados, já que é impossível nomear a dimensão ao longo da qual a concatenação ocorre.

Exemplo unidimensional:

Concat({ {2, 3}, {4, 5}, {6, 7} }, 0)

//Output: {2, 3, 4, 5, 6, 7}

Exemplo bidimensional:

let a = { {1, 2},

{3, 4},

{5, 6} };

let b = { {7, 8} };

Concat({a, b}, 0)

//Output: { {1, 2},

// {3, 4},

// {5, 6},

// {7, 8} }

Diagrama:

Para mais informações sobre o StableHLO, consulte StableHLO: concatenar.

Condicional

Consulte também

XlaBuilder::Conditional.

Conditional(predicate, true_operand, true_computation, false_operand,

false_computation)

| Argumentos | Tipo | Semântica |

|---|---|---|

predicate |

XlaOp |

Escalar do tipo PRED |

true_operand |

XlaOp |

Argumento do tipo \(T_0\) |

true_computation |

XlaComputation |

XlaComputation do tipo \(T_0 \to S\) |

false_operand |

XlaOp |

Argumento do tipo \(T_1\) |

false_computation |

XlaComputation |

XlaComputation do tipo \(T_1 \to S\) |

Executa true_computation se predicate for true, false_computation se predicate for false e retorna o resultado.

O true_computation precisa receber um único argumento do tipo \(T_0\) e será

invocado com true_operand, que precisa ser do mesmo tipo. O

false_computation precisa usar um único argumento do tipo \(T_1\) e será

invocado com false_operand, que precisa ser do mesmo tipo. O tipo do valor retornado de true_computation e false_computation precisa ser o mesmo.

Apenas um de true_computation e false_computation será

executado, dependendo do valor de predicate.

Conditional(branch_index, branch_computations, branch_operands)

| Argumentos | Tipo | Semântica |

|---|---|---|

branch_index |

XlaOp |

Escalar do tipo S32 |

branch_computations |

sequência de N XlaComputation |

XlaComputations do tipo \(T_0 \to S , T_1 \to S , ..., T_{N-1} \to S\) |

branch_operands |

sequência de N XlaOp |

Argumentos do tipo \(T_0 , T_1 , ..., T_{N-1}\) |

Executa branch_computations[branch_index] e retorna o resultado. Se branch_index for um S32 que seja < 0 ou >= N, branch_computations[N-1] será executado como a ramificação padrão.

Cada branch_computations[b] precisa receber um único argumento do tipo \(T_b\) e será invocado com branch_operands[b], que precisa ser do mesmo tipo. O tipo do valor retornado de cada branch_computations[b] precisa ser o mesmo.

Apenas um dos branch_computations será executado, dependendo do valor de branch_index.

Para informações sobre o StableHLO, consulte StableHLO: if.

Constante

Consulte também

XlaBuilder::ConstantLiteral.

Produz um output de um literal constante.

Constant(literal)

| Argumentos | Tipo | Semântica |

|---|---|---|

literal |

LiteralSlice |

visualização constante de um Literal |

Para informações sobre o StableHLO, consulte StableHLO: constante.

ConvertElementType

Consulte também

XlaBuilder::ConvertElementType.

Semelhante a um static_cast independente em C++, o ConvertElementType realiza

uma operação de conversão independente de uma forma de dados para uma forma de destino. As dimensões precisam corresponder, e a conversão é elemento a elemento. Por exemplo, elementos s32 se tornam elementos f32 por uma rotina de conversão de s32 para f32.

ConvertElementType(operand, new_element_type)

| Argumentos | Tipo | Semântica |

|---|---|---|

operand |

XlaOp |

matriz do tipo T com dimensões D |

new_element_type |

PrimitiveType |

tipo U |

As dimensões do operando e do formato de destino precisam ser iguais. Os tipos de elementos de origem e destino não podem ser tuplas.

Uma conversão como T=s32 para U=f32 vai executar uma rotina de conversão de int para float normalizadora, como arredondamento para o número par mais próximo.

let a: s32[3] = {0, 1, 2};

let b: f32[3] = convert(a, f32);

then b == f32[3]{0.0, 1.0, 2.0}

Para informações sobre o StableHLO, consulte StableHLO: converter.

Conv (convolução)

Consulte também

XlaBuilder::Conv.

Calcula uma convolução do tipo usado em redes neurais. Aqui, uma convolução pode ser considerada como uma janela n-dimensional que se move por uma área de base n-dimensional, e um cálculo é realizado para cada posição possível da janela.

Conv Enfileira uma instrução de convolução no cálculo, que usa os números de dimensão de convolução padrão sem dilatação.

O padding é especificado de forma abreviada como SAME ou VALID. O padding SAME preenche a entrada (lhs) com zeros para que a saída tenha o mesmo formato da entrada quando não considera o stride. O preenchimento VALID significa

que não há preenchimento.

Conv(lhs, rhs, window_strides, padding, feature_group_count,

batch_group_count, precision_config, preferred_element_type)

| Argumentos | Tipo | Semântica |

|---|---|---|

lhs

|

XlaOp

|

Matriz (n+2)-dimensional de entradas |

rhs

|

XlaOp

|

Matriz (n+2)-dimensional de pesos do kernel |

window_strides |

ArraySlice<int64> |

Matriz n-dimensional de strides do kernel |

padding |

Padding |

enum de padding |

feature_group_count

|

int64 | o número de grupos de recursos |

batch_group_count |

int64 | o número de grupos de lotes |

precision_config

|

opcional

PrecisionConfig |

enum para nível de precisão |

preferred_element_type

|

opcional

PrimitiveType |

enum do tipo de elemento escalar |

Há níveis crescentes de controles disponíveis para Conv:

Seja n o número de dimensões espaciais. O argumento lhs é uma matriz (n+2)-dimensional que descreve a área de base. Isso é chamado de entrada, embora o lado direito também seja uma entrada. Em uma rede neural, essas são as ativações de entrada. As dimensões n+2 são, nesta ordem:

batch: cada coordenada nessa dimensão representa uma entrada independente para a qual a convolução é realizada.z/depth/features: cada posição (y,x) na área de base tem um vetor associado a ela, que entra nessa dimensão.spatial_dims: descreve as dimensões espaciaisnque definem a área base em que a janela se move.

O argumento rhs é uma matriz (n+2)-dimensional que descreve o filtro/kernel/janela convolucional. As dimensões são, nesta ordem:

output-z: a dimensãozda saída.input-z: o tamanho dessa dimensão vezesfeature_group_countprecisa ser igual ao tamanho da dimensãozno lado esquerdo.spatial_dims: descreve as dimensões espaciaisnque definem a janela n-d que se move pela área de base.

O argumento window_strides especifica a extensão da janela convolucional

nas dimensões espaciais. Por exemplo, se o stride na primeira dimensão espacial for 3, a janela só poderá ser colocada em coordenadas em que o primeiro índice espacial seja divisível por 3.

O argumento padding especifica a quantidade de padding de zero a ser aplicada à área de base. A quantidade de padding pode ser negativa. O valor absoluto do padding negativo indica o número de elementos a serem removidos da dimensão especificada antes de fazer a convolução. padding[0] especifica o padding para a dimensão y, e padding[1] especifica o padding para a dimensão x. Cada par tem o padding baixo como o primeiro elemento e o padding alto como o segundo. O padding baixo é aplicado na direção de índices menores, enquanto o padding alto é aplicado na direção de índices maiores. Por exemplo, se padding[1] for (2,3), haverá um padding de dois zeros à esquerda e três zeros à direita na segunda dimensão espacial. Usar padding é equivalente a inserir esses mesmos valores zero na entrada (lhs) antes de fazer a convolução.

Os argumentos lhs_dilation e rhs_dilation especificam o fator de dilatação a ser aplicado ao lado esquerdo e direito, respectivamente, em cada dimensão espacial. Se o fator de dilatação em uma dimensão espacial for d, d-1 furos serão implicitamente colocados entre cada uma das entradas nessa dimensão, aumentando o tamanho da matriz. Os buracos são preenchidos com um valor nulo, que para convolução significa zeros.

A dilatação do rhs também é chamada de convolução atrous. Para mais detalhes, consulte

tf.nn.atrous_conv2d. A dilatação do lado esquerdo também é chamada de convolução transposta. Para mais detalhes, consulte tf.nn.conv2d_transpose.

O argumento feature_group_count (valor padrão 1) pode ser usado para convoluções agrupadas. feature_group_count precisa ser um divisor da dimensão de recurso de entrada e de saída. Se feature_group_count for maior que 1, isso significa que, conceitualmente, a dimensão do recurso de entrada e saída e a dimensão do recurso de saída rhs serão divididas igualmente em muitos grupos feature_group_count, cada um consistindo em uma subsequência consecutiva de recursos. A dimensão do recurso de entrada de rhs precisa ser igual à dimensão do recurso de entrada de lhs dividida por feature_group_count. Assim, ela já tem o tamanho de um grupo de recursos de entrada. Os grupos i-ésimos são usados juntos para calcular feature_group_count para muitas convoluções separadas. Os resultados dessas convoluções são concatenados na dimensão da característica de saída.

Para a convolução por profundidade, o argumento feature_group_count seria definido como a dimensão do recurso de entrada, e o filtro seria redimensionado de [filter_height, filter_width, in_channels, channel_multiplier] para [filter_height, filter_width, 1, in_channels * channel_multiplier]. Para mais detalhes, consulte tf.nn.depthwise_conv2d.

O argumento batch_group_count (valor padrão 1) pode ser usado para filtros agrupados durante a backpropagation. batch_group_count precisa ser um divisor do tamanho da dimensão do lote lhs (entrada). Se batch_group_count for maior que 1, isso significa que a dimensão do lote de saída deve ter o tamanho input batch

/ batch_group_count. O batch_group_count precisa ser um divisor do tamanho do recurso de saída.

O formato da saída tem estas dimensões, nesta ordem:

batch: o tamanho dessa dimensão vezesbatch_group_countprecisa ser igual ao tamanho da dimensãobatchem lhs.z: mesmo tamanho queoutput-zno kernel (rhs).spatial_dims: um valor para cada posição válida da janela convolucional.

A figura acima mostra como o campo batch_group_count funciona. Efetivamente, dividimos cada lote do lado esquerdo em batch_group_count grupos e fazemos o mesmo com os recursos de saída. Em seguida, para cada um desses grupos, fazemos convoluções aos pares e concatenamos a saída ao longo da dimensão do recurso de saída. A semântica operacional de todas as outras dimensões (recurso e espacial) permanece a mesma.

As posições válidas da janela convolucional são determinadas pelas strides e pelo tamanho da área da base após o padding.

Para descrever o que uma convolução faz, considere uma convolução 2D e escolha algumas coordenadas fixas batch, z, y, x na saída. Então, (y,x) é uma posição de um canto da janela dentro da área de base (por exemplo, o canto superior esquerdo, dependendo de como você interpreta as dimensões espaciais). Agora temos uma janela 2D, extraída da área de base, em que cada ponto 2D está associado a um vetor 1D, resultando em uma caixa 3D. Do kernel convolucional, como fixamos a coordenada de saída z, também temos uma caixa 3D. As duas caixas têm as mesmas dimensões. Portanto, podemos somar os produtos elemento a elemento entre elas (semelhante a um produto escalar). Esse é o valor de saída.

Se output-z for, por exemplo, 5, cada posição da janela produz cinco valores na saída para a dimensão z. Esses valores diferem na parte do kernel convolucional usada. Há uma caixa 3D separada de valores usada para cada coordenada output-z. Então, pense nisso como cinco convoluções separadas com um filtro diferente para cada uma delas.

Confira um pseudocódigo para uma convolução 2D com padding e stride:

for (b, oz, oy, ox) { // output coordinates

value = 0;

for (iz, ky, kx) { // kernel coordinates and input z

iy = oy*stride_y + ky - pad_low_y;

ix = ox*stride_x + kx - pad_low_x;

if ((iy, ix) inside the base area considered without padding) {

value += input(b, iz, iy, ix) * kernel(oz, iz, ky, kx);

}

}

output(b, oz, oy, ox) = value;

}

precision_config é usado para indicar a configuração de precisão. O nível

determina se o hardware deve tentar gerar mais instruções de código de máquina

para fornecer uma emulação de dtype mais precisa quando necessário (ou seja,

emular f32 em uma TPU que só aceita bf16 matmuls). Os valores podem ser

DEFAULT, HIGH, HIGHEST. Mais detalhes nas seções da MXU.

preferred_element_type é um elemento escalar de tipos de saída de precisão maior/menor usado para acumulação. preferred_element_type recomenda o tipo de acumulação para a operação especificada, mas não há garantia. Isso permite que alguns backends de hardware acumulem em um tipo diferente e convertam para o tipo de saída preferido.

Para informações sobre o StableHLO, consulte StableHLO: convolução.

ConvWithGeneralPadding

Consulte também

XlaBuilder::ConvWithGeneralPadding.

ConvWithGeneralPadding(lhs, rhs, window_strides, padding,

feature_group_count, batch_group_count, precision_config,

preferred_element_type)

Igual a Conv, em que a configuração de padding é explícita.

| Argumentos | Tipo | Semântica |

|---|---|---|

lhs

|

XlaOp

|

Matriz (n+2)-dimensional de entradas |

rhs

|

XlaOp

|

Matriz (n+2)-dimensional de pesos do kernel |

window_strides |

ArraySlice<int64> |

Matriz n-dimensional de strides do kernel |

padding

|

ArraySlice<

pair<int64,int64>> |

Matriz n-d de padding (baixo, alto) |

feature_group_count

|

int64 | o número de grupos de recursos |

batch_group_count |

int64 | o número de grupos de lotes |

precision_config

|

opcional

PrecisionConfig |

enum para nível de precisão |

preferred_element_type

|

opcional

PrimitiveType |

enum do tipo de elemento escalar |

ConvWithGeneralDimensions

Consulte também

XlaBuilder::ConvWithGeneralDimensions.

ConvWithGeneralDimensions(lhs, rhs, window_strides, padding,

dimension_numbers, feature_group_count, batch_group_count, precision_config,

preferred_element_type)

Igual a Conv, em que os números de dimensão são explícitos.

| Argumentos | Tipo | Semântica |

|---|---|---|

lhs

|

XlaOp

|

Matriz de entradas (n+2)-dimensional |

rhs

|

XlaOp

|

Matriz (n+2)-dimensional de pesos do kernel |

window_strides

|

ArraySlice<int64>

|

Matriz n-dimensional de strides do kernel |

padding |

Padding |

enum de padding |

dimension_numbers

|

ConvolutionDimensionNumbers

|

o número de dimensões |

feature_group_count

|

int64 | o número de grupos de recursos |

batch_group_count

|

int64 | o número de grupos de lotes |

precision_config

|

opcional PrecisionConfig

|

enum para nível de precisão |

preferred_element_type

|

opcional PrimitiveType

|

enum do tipo de elemento escalar |

ConvGeneral

Consulte também

XlaBuilder::ConvGeneral.

ConvGeneral(lhs, rhs, window_strides, padding, dimension_numbers,

feature_group_count, batch_group_count, precision_config,

preferred_element_type)

Igual a Conv, em que os números de dimensão e a configuração de padding são explícitos.

| Argumentos | Tipo | Semântica |

|---|---|---|

lhs

|

XlaOp

|

Matriz de entradas (n+2)-dimensional |

rhs

|

XlaOp

|

Matriz (n+2)-dimensional de pesos do kernel |

window_strides

|

ArraySlice<int64>

|

Matriz n-dimensional de strides do kernel |

padding

|

ArraySlice<

pair<int64,int64>>

|

Matriz n-dimensional de padding (baixo, alto) |

dimension_numbers

|

ConvolutionDimensionNumbers

|

o número de dimensões |

feature_group_count

|

int64 | o número de grupos de recursos |

batch_group_count

|

int64 | o número de grupos de lotes |

precision_config

|

opcional PrecisionConfig

|

enum para nível de precisão |

preferred_element_type

|

opcional PrimitiveType

|

enum do tipo de elemento escalar |

ConvGeneralDilated

Consulte também

XlaBuilder::ConvGeneralDilated.

ConvGeneralDilated(lhs, rhs, window_strides, padding, lhs_dilation,

rhs_dilation, dimension_numbers, feature_group_count, batch_group_count,

precision_config, preferred_element_type, window_reversal)

Igual a Conv, em que a configuração de padding, os fatores de dilatação e os números de dimensão são explícitos.

| Argumentos | Tipo | Semântica |

|---|---|---|

lhs

|

XlaOp

|

Matriz de entradas (n+2)-dimensional |

rhs

|

XlaOp

|

Matriz (n+2)-dimensional de pesos do kernel |

window_strides

|

ArraySlice<int64>

|

Matriz n-dimensional de strides do kernel |

padding

|

ArraySlice<

pair<int64,int64>>

|

Matriz n-dimensional de padding (baixo, alto) |

lhs_dilation

|

ArraySlice<int64>

|

Matriz de fatores de dilatação do lado esquerdo n-d |

rhs_dilation

|

ArraySlice<int64>

|

Matriz de fatores de dilatação do RHS n-d |

dimension_numbers

|

ConvolutionDimensionNumbers

|

o número de dimensões |

feature_group_count

|

int64 | o número de grupos de recursos |

batch_group_count

|

int64 | o número de grupos de lotes |

precision_config

|

opcional PrecisionConfig

|

enum para nível de precisão |

preferred_element_type

|

opcional PrimitiveType

|

enum do tipo de elemento escalar |

window_reversal

|

opcional vector<bool>

|

flag usada para inverter logicamente a dimensão antes de aplicar a convolução |

Copiar

Consulte também

HloInstruction::CreateCopyStart.